Transformer模型深度解读 精读 (transferwise)

字幕组双语原文,精读,Transformer模型深度解读英语原文,TheAnnotatedTransformerfromIPython.displayimportImageImage,filename=images,aiayn.png,在过去的一年里,,注意力就是你所需要的,中的Transformer被很多人所关注,除了在翻译质量上...。

10倍GPT

新一代人工智能已经迈向,炼大模型,的时代,这一切源于GPT,3的横空出世,这个具有1750亿的参数的通用预训练模型不仅带来了超乎想象的生成能力,更让人们看到了,超大模型,实现通用人工智能的潜力,2021年1月,距离GPT,3问世不足一年,Google重磅推出SwitchTransformer模型,将参数量提升到1.6万亿,成为人类历史...。

数字人 支持NVIDIA 终端AI助手 悟道 GTX单卡机运行百亿大模型 首次落地 全球最大智能模型 (数字人ecdh)

悟道2.0,要怎么用起来,连创,中国首个,和,世界最大,两项记录后,悟道大模型的落地应用成为业界关心的热点话题,GPT,3的问世掀起了一股,炼大模型,的浪潮,去年10月,北京智源研究院集结中国产学界100多位AI专家联合攻关,在一年之内发布了1.75万亿级大规模预训练模型悟道2.0,超越GPT,3、SwitchTransformer,...。

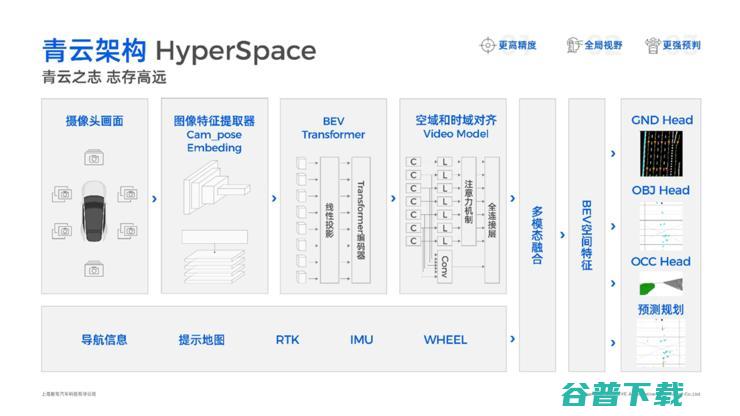

启明星计划 智驾科技MAXIEYE发布 面向全行业开放BEV感知标准件 (启明星 计划)

自动驾驶行业的前路共识初显,丢掉传统CNN包袱,拥抱基于BEV,transformer的数据驱动模式已是大势所趋,在智驾科技MAXIEYE,以下简称,MAXIEYE,创始人周圣砚看来,未来BEV,transformer大模型可能会完全淘汰基于规则的自动驾驶算法,成为行业标配,11月29日,MAXIEYE召开主题为,虚实之间,BEV新...。

知识图谱的全方位总结 ACL 2019 (知识图谱的全称是什么)

雷锋网AI科技评论,ACL2019已经结束,但其空前的规模仍然震撼人心,2900多篇提交论文,660篇被接收,3000多名会议注册人员,以及4个超过400人的研讨会,比一些国际CS会议都大,值得一提的是,在本届ACL中热门话题,例如BERT系列、Transformers、机器翻译等,受到热烈关注,但除此之外还有一些新的趋势,例如对抗...。

出题 解题 评分样样都行 当AI学会高数 (题目打分)

高等数学里程碑式的研究,,114页论文让AI文理双修,也许不久后机器出的高数试卷就会走进高校课堂,这下可以说,高数题不是人出的了,编译,王晔人工智能虽然给我们带来了诸多便利,但也不免受到了各种质疑,在互联网领域表现良好的人工智能,在数学领域的很多表现却被认为是,出乎意料地糟糕,基于Transformers的语言模型在零样本和少样...。

基于序列对比学习的长视频逐帧动作表征 浙大蔡登团队 (序列对比算法)

浙大蔡登团队携手微软亚洲研究院,提出了一个新的对比动作表征学习,CARL,框架,以自监督的方式学习逐帧动作表征,尤其是针对长视频;它考虑了时空上下文来提取逐帧表征,是一种基于Transformer的简单而高效的视频编码器,他们提出了一种新的序列对比损失,SCL,,应用于通过一系列时空数据增强获得的两个相关的视图,在FineGym、Pe...。

少于两层的transformer GPT 且只有注意力块 (两层以上含两层不得设置防盗窗)

只有一层或两层、且只有注意力块的transformer,在性能上有望达到96层、兼具注意力块与MLP块的GPT,3的效果吗,在过去的两年里,基于Transformer架构开发的大规模语言模型在性能,如语言流畅度,上达到了令人叹为观止的效果,但是,Transformer对单词的处理方法是什么,学术界仍未有确定的答案,普遍的理解是,tra...。

轻松应对高难度长文本序列 这六大方法 如何让 Transformer (轻松应对高难度的工作)

众所周知,多头注意力机制,Multi,HeadSelf,Attention,的计算开销很大,在处理长度为n的序列时,其O,n²,的时间复杂度会使得原始的Transformer模型难以处理长文本序列,在过去的两年里,已经出现了多种有效的方法来应对多头注意力机制的复杂度问题,本文将重点讨论在模型规模方面很有发展前景的方法,一、密集型多头注...。

长程上下文综述 Transformers

字幕组双语原文,Transformers长程上下文综述英语原文,ASurveyofLong,TermContextinTransformers多头自注意力开销很大,这已经不是什么秘密了——序列长度的O,n²,复杂度意味着不太可能让经典的Transformer模型处理超长文本序列,在过去的两年里,NLP社区已经开发出了名副其实的缝合怪方...。

开放代码又如何 资源集中 成本昂贵 大规模语言模型的民主化越来越难 (开放原代码许可)

5月初,Meta发布了一个可以执行多个不同任务的大型语言模型,OpenpretrainingTransformer,OPT,175B,在过去几年里,大型语言模型,largelanguagemodel,LLM,已经成为人工智能研究的热点之一,在OpenAI发布包含1750亿参数的深度神经网络GPT,3之后,就引发了一场LLM的,军备竞...。

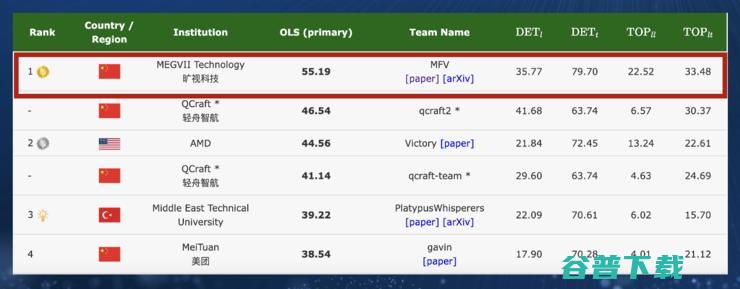

成熟了 旷视的自动驾驶果实 蛰伏两年 (成熟的潜台词是什么)

自动驾驶圈正被,去高精地图,风暴席卷,出人意料地,打败众竞争对手,摘下桂冠的,是一家此前从未向外公布过有自动驾驶业务的中国AI公司——旷视科技,旷视在这届自动驾驶国际挑战赛的表现相当亮眼,CVPR2023自动驾驶国际挑战赛分为四个赛道,包括OpenLane拓扑关系赛道、OnlineHDMapConstruction,在线高精地图构建,...。

用Transformer做线代作业 真香! (用transportation造句简单)

线性代数,linearalgebra,是关于向量空间和线性映射的一个数学分支,现代线性代数的历史可以上溯到19世纪中期的英国,1843年,爱尔兰数学家哈密顿发现四元数,1844年,赫尔曼·格拉斯曼发表他的著作,线性外代数,DielineareAusdehnungslehre,,包括今日线性代数的一些主题,1848年,詹姆斯·西尔维斯...。

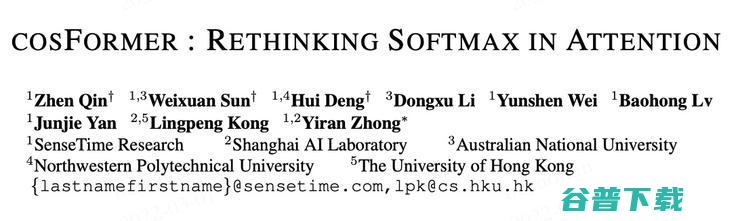

cosFormer ICLR 重新思考注意力机制中的Softmax 2022 (cosforge)

导读,Transformer在自然语言处理、计算机视觉和音频处理方面取得了巨大成功,作为其核心组成部分之一,SoftmaxAttention模块能够捕捉长距离的依赖关系,但由于Softmax算子关于序列长度的二次空间和时间复杂性,使其很难扩展,针对这点,研究者提出利用核方法以及稀疏注意力机制的方法来近似Softmax算子,从而降低时间...。

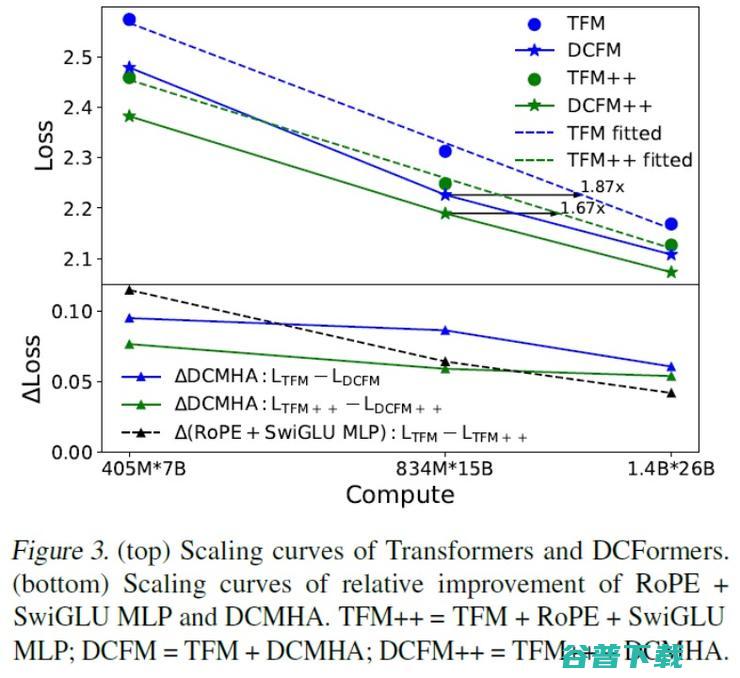

彩云科技DCFormer模型架构发布 效率是Transformer的两倍! (彩云科技大模型)

自2017年Transformer架构诞生之后,到现在为止其仍然是人工智能领域研究和应用的基础,鲜少有团队能够在最底层架构上进行一些变革和开发且做出较大的成效,一方面是由于Transformer确实好用;另一方面,在最底层上做突破并非易事,然而,彩云科技是那个反共识者,2024年5月22日,彩云科技发布了全新通用模型结构DCForme...。

Yan1.3解密AGI新路径 当端侧革新遇见群体智能 (腌13斤肉要多少盐)

消息,9月26日,RockAI,真端侧·智无界,开放日活动在上海举行,正式推出了全新升级的Yan1.3大模型,并展示了其在无人机、机器人、PC、手机等各类终端设备上的超强模力,相较于1月份首发的Yan1.0,Yan1.3具备了强大的多模态能力,可高效处理图文及语音等多模态信息,并实现了模型在更广泛设备端上的离线无损部署,普通电...。

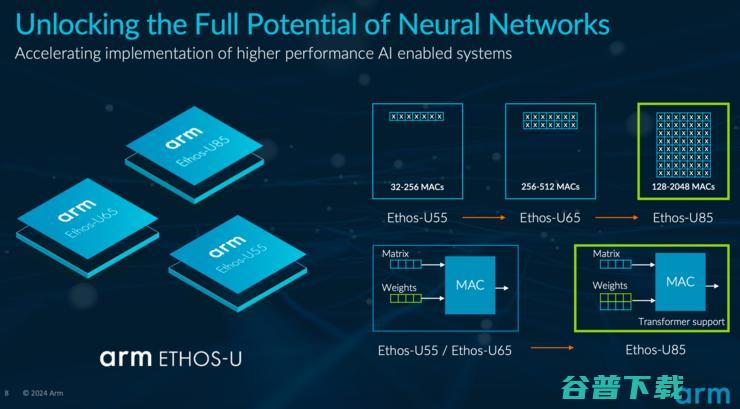

Arm全新NPU性能提升4倍 支持Transformer 边缘生成式AI时代指日可待 (arm全新架构)

生成式AI在经历了火热的百模大战之后,开始进入落地阶段,以工业机器视觉、可穿戴设备和消费者机器人为代表的边缘应用,无疑是生成式AI落地的重要场景,本周,Arm宣布推出了性能相比前代提升4倍的ArmEthos,U85神经网络处理器,NPU,,这是一款硬件支持Transformer架构和卷积神经网络,CNN,的AI加速器,能够以高能效实现...。

用 限制 图机器学习无处不在 Transformer 可缓解 GNN (限制性作图的基本原理和方法)

在我们今天的生活中,图的示例包括社交网络、例如Twitter、Mastodon、以及任何链接论文和作者的引文网络,分子,知识图、例如UML图、百科全书以及有超链接的网站,表示为句法树的句子以及任何的3D网格等,可以说图已经无处不在,近日,HuggingFace研究科学家ClémentineFourrier在文章,Introductio...。