MoE A 高效训练的

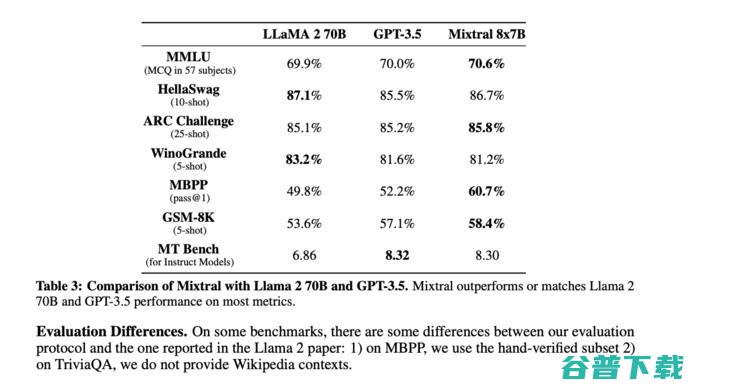

MoE会成为未来大模型训练的新方向吗,这是人们发现MoE架构可以用于大模型训练、推理后,发出的一声疑问,MoE,MixtureofExperts,,又称,混合专家,,本质是一种模块化的稀疏激活,怎么理解,当前的大模型主要分为稠密,dense,模型与稀疏,sparse,模型,两者的区别主要在于模型进行计算时,被调用的参数数量,参数全部生...。

SparseGPT 来了 首个千亿模型压缩算法 降低算力成本的同时保持高精度 (sparsely 翻译)

自2020年GPT,3横空出世以来,ChatGPT的爆火再一次将GPT家族的生成式大型语言模型带到聚光灯下,它们在各种任务中都已显示出了强大的性能,但模型的庞大规模也带来了计算成本的上升和部署难度的增加,比如,GPT‑175B模型总计至少占320GB半精度,FP16,格式的存储空间,在推理时,起码需要五个80GB存储空间的A100GP...。

Scipy.sparse矩阵的存储,读取和转化为稠密矩阵-Python

importnumpyasnpimportscipy.sparseasspm=sp.lil_matrix((7329,7329))np.save(path,m)#用numpy的load方法存储矩阵,path为存储的路径