是时候放弃循环神经网络了! (是时候放弃了)

有人说,不同语言之间的翻译,与其说是一门科学,不如说是一门艺术,NLP领域的机器学习工程师RiccardoDiSipio日前提出了一个观点,使用卷积网络要比使用循环神经网络来做NLP研究,要幸福得多——是时候放弃循环神经网络了!基于这一观点,他从卷积网络本身的基本原理出发,论述了为什么NLP不再需要循环神经网络的原因,我们来看,不久前...。

轻松应对高难度长文本序列 这六大方法 如何让 Transformer (轻松应对高难度的工作)

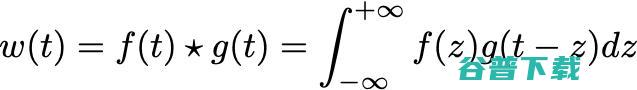

众所周知,多头注意力机制,Multi,HeadSelf,Attention,的计算开销很大,在处理长度为n的序列时,其O,n²,的时间复杂度会使得原始的Transformer模型难以处理长文本序列,在过去的两年里,已经出现了多种有效的方法来应对多头注意力机制的复杂度问题,本文将重点讨论在模型规模方面很有发展前景的方法,一、密集型多头注...。

AAAI2022丨创新奇智提出双注意力机制少样本学习 助力工业场景细粒度识别 (aaai2025审稿结果)

近日,创新奇智关于双注意力机制少样本学习的研究论文,DualAttentionNetworksforFew,ShotFine,GrainedRecognition,被全球人工智能顶会接收为MainTrack论文,AAAI,TheNationalConferenceonArtificialIntelligence,是人工智能领域的主要学...。

用Transformer做线代作业 真香! (用transportation造句简单)

线性代数,linearalgebra,是关于向量空间和线性映射的一个数学分支,现代线性代数的历史可以上溯到19世纪中期的英国,1843年,爱尔兰数学家哈密顿发现四元数,1844年,赫尔曼·格拉斯曼发表他的著作,线性外代数,DielineareAusdehnungslehre,,包括今日线性代数的一些主题,1848年,詹姆斯·西尔维斯...。

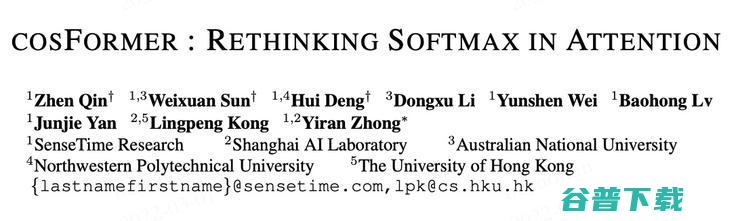

cosFormer ICLR 重新思考注意力机制中的Softmax 2022 (cosforge)

导读,Transformer在自然语言处理、计算机视觉和音频处理方面取得了巨大成功,作为其核心组成部分之一,SoftmaxAttention模块能够捕捉长距离的依赖关系,但由于Softmax算子关于序列长度的二次空间和时间复杂性,使其很难扩展,针对这点,研究者提出利用核方法以及稀疏注意力机制的方法来近似Softmax算子,从而降低时间...。