神经网络无法实现可解释 重温三十年前对于 NN AI 的批判 (神经网络无法收敛)

美国东北大学体验式人工智能研究所的高级研究科学家WalidS.Saba从组合语义的角度出发,提出一个观点,深度学习无法构造一个可逆的组合语义,所以它无法实现可解释AI,可解释AI,XAI,随着深度神经网络,DNN,用于决定贷款批准、工作申请、批准法院保释等与人们利益息息相关或者一些生死攸关的决定,例如在高速公路上突然停车,,去解释这些...。

不要迷信可解释性 佐治亚理工学院发文 小心被误导 (不能迷信)

可解释性对人工智能发展来说至关重要,但在可解释系统的可信度方面,理解其可能带来的负面效应亦同等重要,近日,佐治亚理工学院研究团队发表最新研究,重点讨论了可解释人工智能系统,XAI,中一种重要却未被阐明的负面效应,在这篇论文中,作者提出,可解释性陷阱,EPs,的概念,指出即使设计者最初没有操控用户的意图,模型的可解释性也可能带来意料之...。

腾讯发布国内首份可解释AI报告!层层分析 套娃式 AI算法 (腾讯出台)

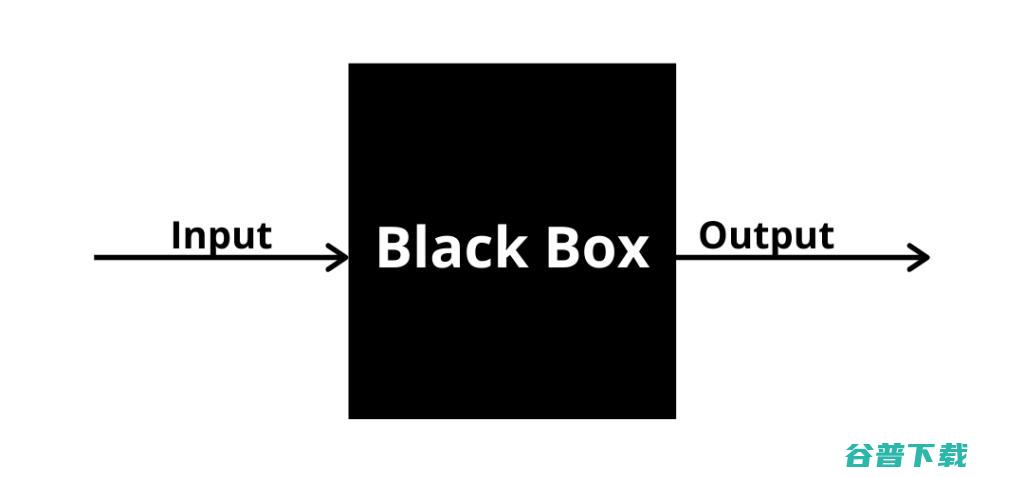

打开一个黑盒子,黑盒子变成了白盒子,但是白盒子中又出现了更多的黑盒子,探索可解释AI是一条长远的道路,在刚刚过去的2021年,人工智能领域最热门的新兴话题之一,就是,可信AI,2021年6月,蚂蚁集团在全球人工智能大会上首次公布,可信AI,技术架构体系;7月,京东探索研究院又在世界人工智能大会上发布中国首个,可信人工智能白皮书,,且...。

可解释的人工智能和可解释的机器学习:照亮黑匣子

随着人工智能系统变得越来越复杂,经常做出难以理解或解释的决策。因此,可解释人工智能(XAI)和可解释机器学习的概念出现了,这两种开创性的方法旨在揭示人工智能模型的内部工作原理,使专家和非专家都可以透明...