为什么深度学习是非参数的

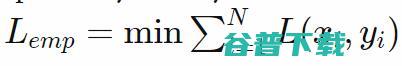

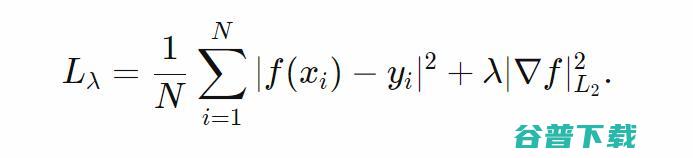

最小化。如果我们的损失函数是负对数似然,将

最小化。如果我们的损失函数是负对数似然,将

最最小化就意味着计算最大相似估计。

最最小化就意味着计算最大相似估计。

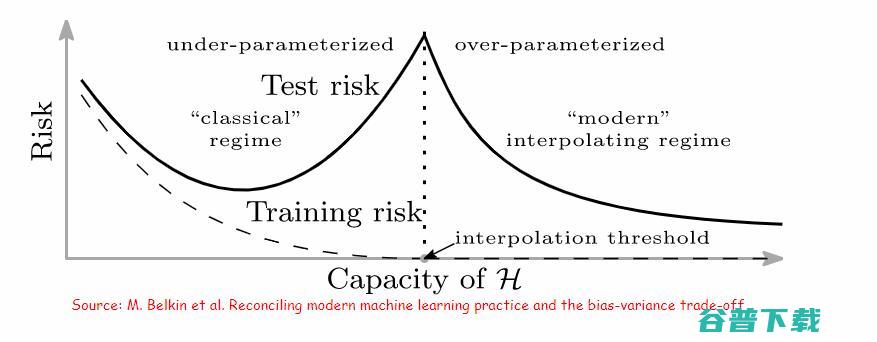

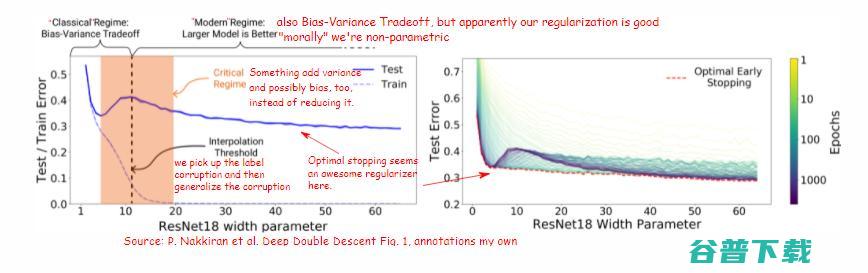

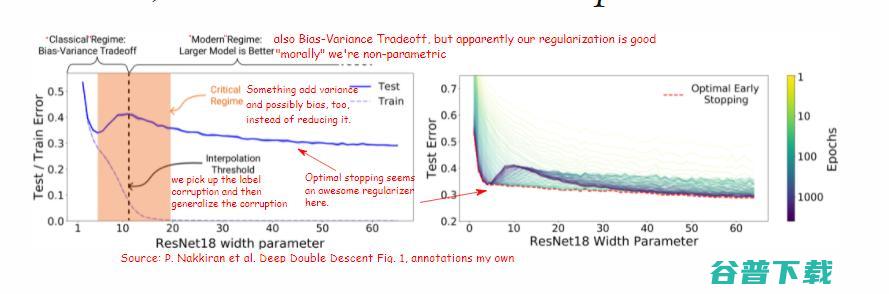

对偏差-方差分解和偏差-方差平衡的简单介绍

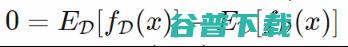

中采得的随机变量,且我们训练的模型

f依赖于

D,记作

中采得的随机变量,且我们训练的模型

f依赖于

D,记作

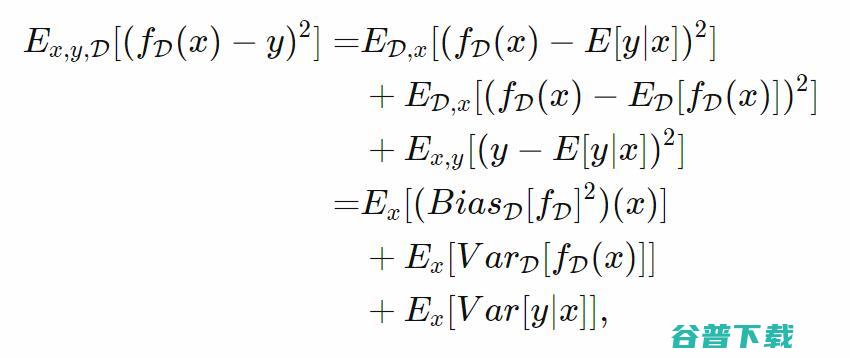

并利用(,)和D的独立性,我们可以将预测的期望平方误差分解为:

并利用(,)和D的独立性,我们可以将预测的期望平方误差分解为:

,我们可以让方差为0,这样则是极端的欠拟合。

,我们可以让方差为0,这样则是极端的欠拟合。

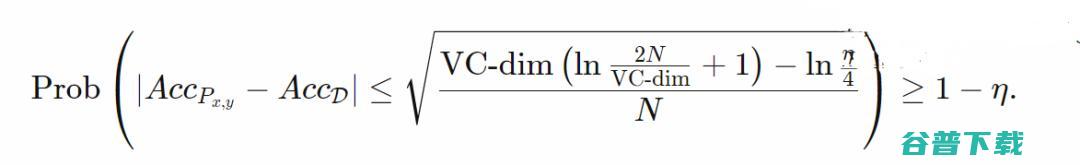

的大小或其VC维的项。此处的典型情况是,一个人想要≥VC-dim个样本,却可能有≤20VC-dim个样本。但请注意,这里参数的数量不是标准的一部分(但可能会影响VC维)。

的大小或其VC维的项。此处的典型情况是,一个人想要≥VC-dim个样本,却可能有≤20VC-dim个样本。但请注意,这里参数的数量不是标准的一部分(但可能会影响VC维)。

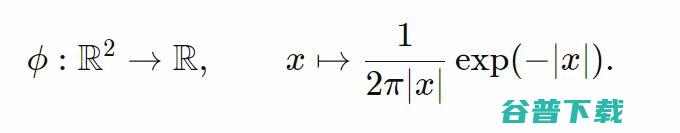

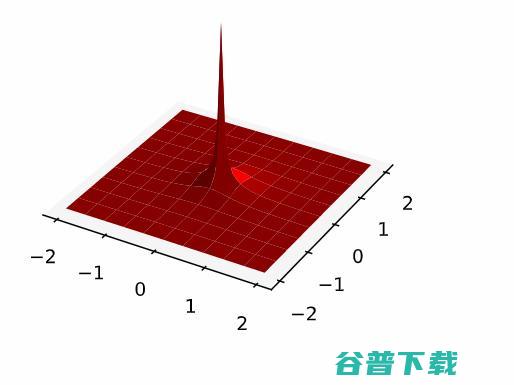

里有弱导数的索伯列夫函数空间

里有弱导数的索伯列夫函数空间

(无论采用何种测度,是x的分布抑或是包含输入的

(无论采用何种测度,是x的分布抑或是包含输入的

的勒贝格测度),我们可以匹配任意有限样本D上每一点的样本均值,从而可以获得0点态偏差, 但是最小化经验风险是病态的,有无限多的解。

的勒贝格测度),我们可以匹配任意有限样本D上每一点的样本均值,从而可以获得0点态偏差, 但是最小化经验风险是病态的,有无限多的解。

。我们并不想让方差为0,因为我们的正则化项仅仅是一个半范数)。当然了,Grace Wahba有关正则化回归的研究尤其与保持偏差-方差间的良好平衡相关,特别是与如何寻找到一个合适的值相关。

。我们并不想让方差为0,因为我们的正则化项仅仅是一个半范数)。当然了,Grace Wahba有关正则化回归的研究尤其与保持偏差-方差间的良好平衡相关,特别是与如何寻找到一个合适的值相关。

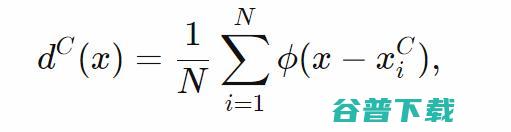

中将经验最小二乘损失(第一项) 最小化,就可以将前一节中的ansatz函数与嵌套空间Fi联系起来。因此来自递增权重序列

中将经验最小二乘损失(第一项) 最小化,就可以将前一节中的ansatz函数与嵌套空间Fi联系起来。因此来自递增权重序列

就给到了我们嵌套的Ansatz空间。

就给到了我们嵌套的Ansatz空间。

在插值条件中挤出错误标记的数据

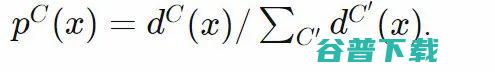

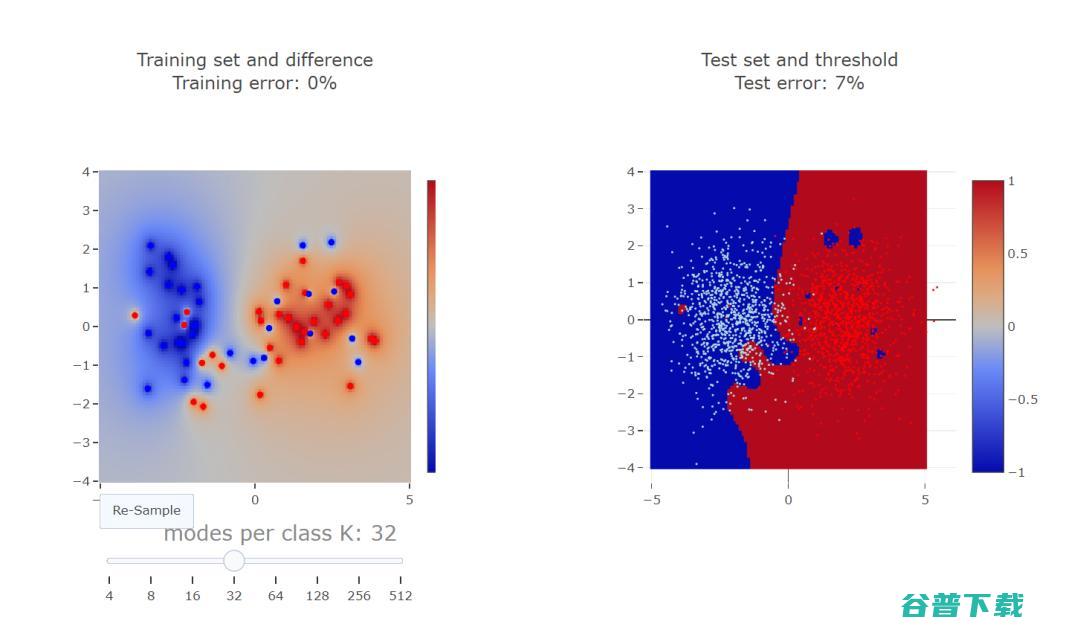

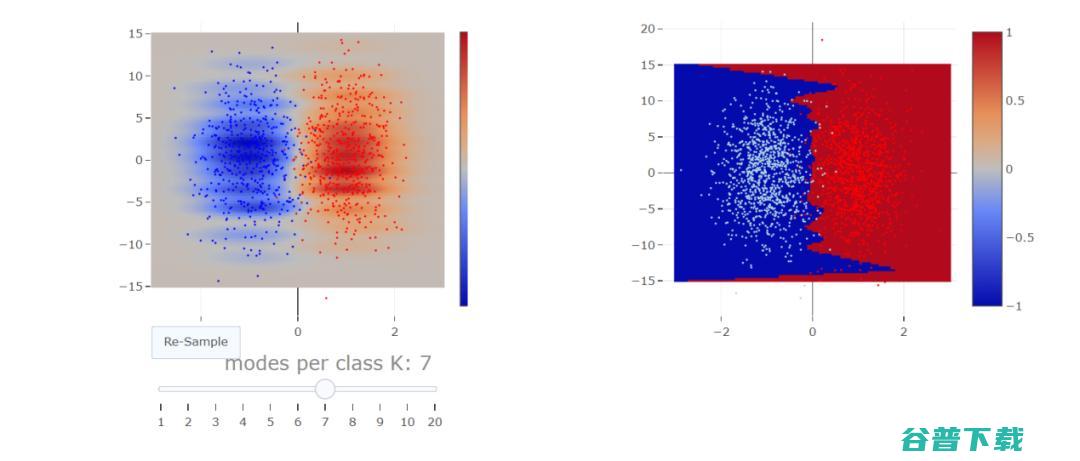

更大的点对每个点进行分类,或者说,如果我们想通过标准化每个点的概率密度来获取概率

更大的点对每个点进行分类,或者说,如果我们想通过标准化每个点的概率密度来获取概率

特征噪声类似于标签噪声

,当⋅+≥0时,类为1;否则,类为0。如果我们预先知道输入是有界的,我们可以找到类原型

,当⋅+≥0时,类为1;否则,类为0。如果我们预先知道输入是有界的,我们可以找到类原型

进行分类。但随后的线性分类器的−1维零空间(null-space)中的向量,比如我们可以添加到输入中而不改变结果的向量空间

进行分类。但随后的线性分类器的−1维零空间(null-space)中的向量,比如我们可以添加到输入中而不改变结果的向量空间

,可能对这个距离有很大帮助,从而使得

,可能对这个距离有很大帮助,从而使得

成为对更相关的投影距离

成为对更相关的投影距离

版权文章,未经授权禁止转载。详情见 转载须知 。