论文解读 基于强化学习的时间行为检测自适应模型 2018 AAAI (论文解读基于什么理论)

雷锋网 AI 科技评论按 :互联网上以视频形式呈现的内容在日益增多,对视频内容进行高效及时的审核也变得越来越迫切。因此,视频中的行为检测技术也是当下热点研究任务之一。本文主要介绍的就是一种比传统视频行为检测方法更加有效的视频行为检测模型。

在近期雷锋网 gair 大讲堂举办的线上公开上,来自北京大学深圳研究生院信息工程学院二年级博士生黄靖佳介绍了他们团队在 AAAI 2018 上投稿的一篇论文,该论文中提出了一种可以自适应调整检测窗口大小及位置的方法,能对视频进行高效的检测。视频回放地址:

黄靖佳,北京大学深圳研究生院信息工程学院二年级博士生。2016 年毕业于华中科技大学计算机学院信息安全专业,获学士学位。现研究方向为计算机视觉、行为检测、增强学习等。

以下是 AI 科技评论对嘉宾分享的内容回顾。

分享主题 :AAAI 2018 论文解读:基于强化学习的时间行为检测自适应模型

分享提纲:

分享内容:

大家好,我的分享首先是介绍一下行为检测的应用背景,接下来介绍我们团队提出的 SAP 模型,以及模型在实验数据集上的性能,最后是对本次分享的总结。

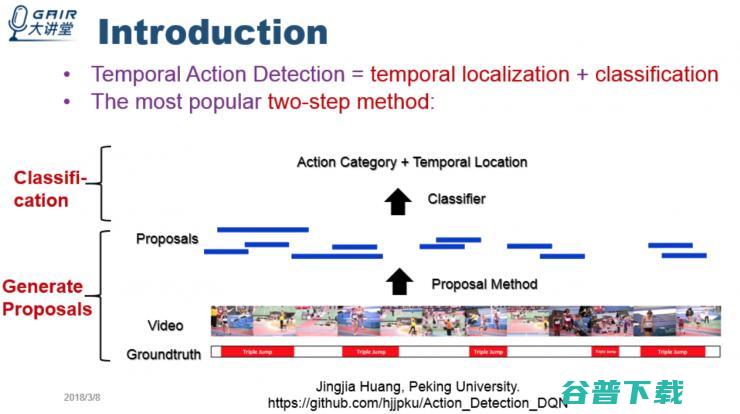

行为检测任务的介绍

但是这种方法在解决任务时存在两个难点。

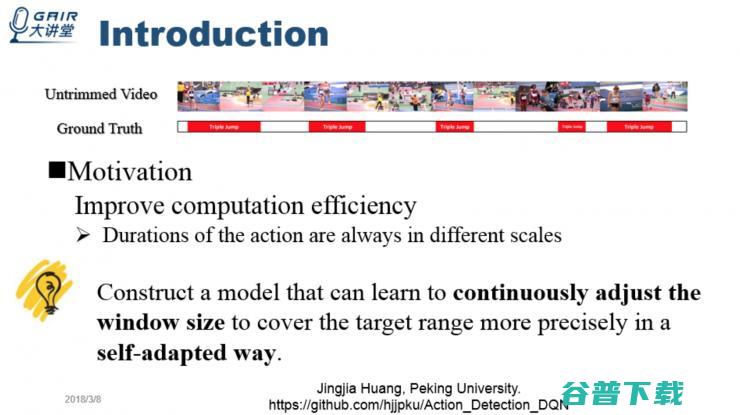

首先是对于一个没有切割过的视频,比如在图中这个视频中,所需要检测的目标是一个三级跳运动,三级跳在不同的情况下,根据人的不同,所持续的时间也是不同的。

第二个难点是,目标时间出现的位置是在视频中的任意时间点。

所以说用「两阶段方法」进行目标行为预测,会产生非常多不同尺度,不同位置 proposal。最简单的方法是用不同尺度的滑动窗口,从前到后滑动,产生非常多的 proposal,然后再做分类。这种方法虽然行之有效,但时间复杂度和计算复杂度都相当高,使得在完成这项任务时往往需要花费大量的计算资源。

为了避免这种低效的检测方法,我们提出了一种可以自适应调整检测窗口大小及位置的方法,对视频进行高效的检测。

我们最开始的想法是能不能仅使用一个滑动窗口,只需要从头到尾滑动一遍就完成 proposal 产生过程呢?

这就必须要求窗口能不断地自适应地根据窗口所覆盖的内容,能够不断调节窗口的大小,最终的窗口大小能精确覆盖目标运动,从而得到检测的窗口区间。

我们使用增强学习作为背后的模型支撑来完成这样的循环过程,达到我们的目的。下面是 SAP 模型的框架图。

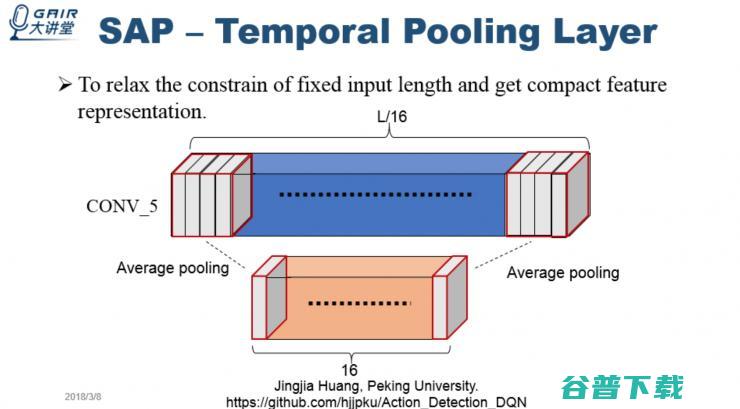

关于 TEMPoral Pooling Layer

在原有的 C3D 模型中,要求输入的视频帧是固定的,一般是 16 帧或 8 帧。以 16 帧为例,当视频帧多于 16 帧,就需要对视频帧下采样,采样成 16 帧,送到视频中进行处理,这样在采样过程中会丢失非常多细节信息,造成特征表达不准确等问题。

而我们提出的 Temporal Pooling Layer 的输入帧可以是任意长度。

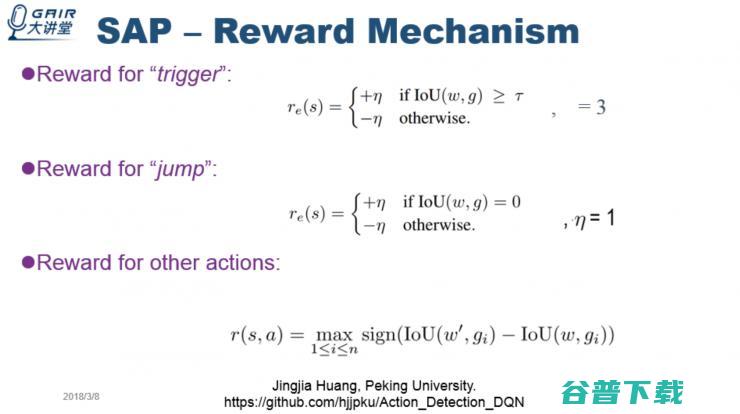

我们在增强学习中的奖励设置机制。在增强学习中,对于一个 agent,如果 agent 执行了一个动作后,我们认为是执行正确的,就给一个奖励;如果认为是错的,就给一个惩罚。

SAP 模型的训练过程,可到文末观看嘉宾的视频回放,或关注嘉宾的 GitHub 地址获取相关代码。

SAP 模型的测试

实验过程

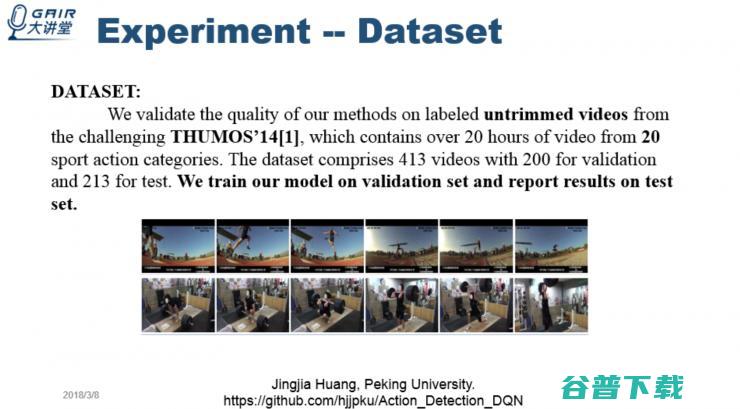

我们的实验是在 THUMOS'14 数据集展开的,用它的 validation set 训练模型,在 test set 上进行实验评估。我们使用了是以下两个衡量标准。第一个是 recall 值和平均 proposal 数量函数第二个是 recall 和 IoU。

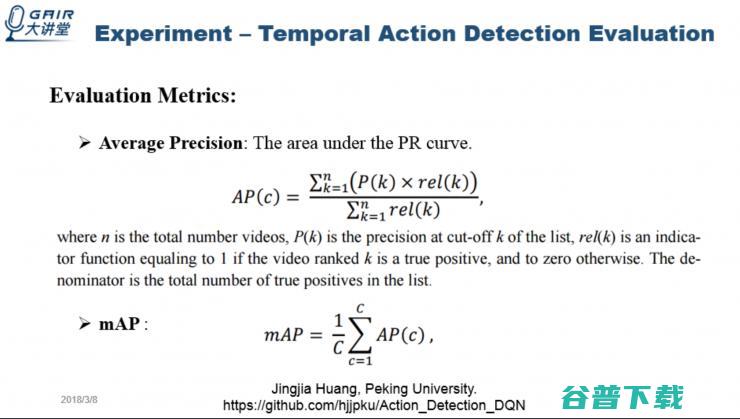

proposal 做分类后的评判标准是:Average Precison 和 mAP

检测性能的结果

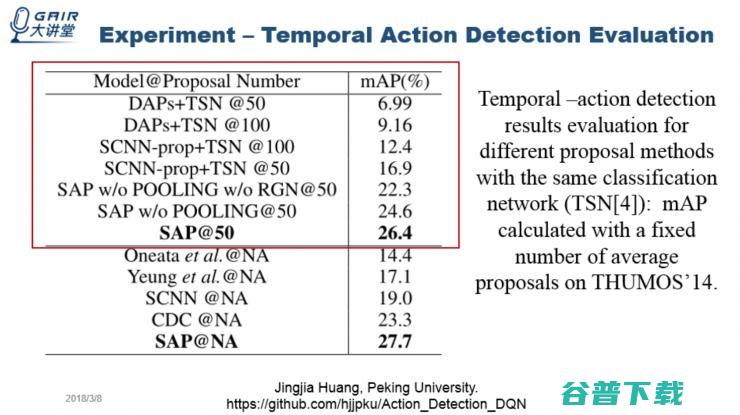

上图红色圈注的部分比较的是不同的模型,在取相同的 proposal 数量,用同样的分类器做分类,哪个模型的性能会更好。结果发现,在只有 50 个 proposal 的时候,我们的方法表现的最好。

总结

代码相关资料GitHub地址:

雷锋网GAIR大讲堂视频回放地址:

更多免费直播视频,请关注微信公众号: AI科技评论。