自动化 可解释性 美国德州农工大学胡侠教授 AI落地开花如何翻过 和 两座大山丨CCF (自动化解释和造句)

雷锋网 AI 掘金志按:7 月 12 日-7 月 14 日,2019 第四届全球人工智能与机器人峰会(CCF-GAIR 2019)于深圳正式召开。峰会由中国计算机学会(CCF)主办,雷锋网、香港中文大学(深圳)承办,深圳市人工智能与机器人研究院协办。

在大会第三天的〖智能商业专场〗,阿里巴巴集团副总裁、CEO助理肖利华,京东零售首席科学家兼技术副总裁胡鲁辉,美国德州农工大学数据挖掘实验室主任胡侠,苏宁零售技术研究院院长王俊杰,TCL研究院 (香港)研究所总经理俞大海,扩博智能CTO柯严先后登台发表精彩演讲,分享了各自对智能商业的理解与实践。

其中美国德州农工大学数据挖掘实验室主任胡侠教授以《增强人工? 促进智能??》为主题,分享了他在深度学习可解释性与自动机器学习方面的最新研究成果。

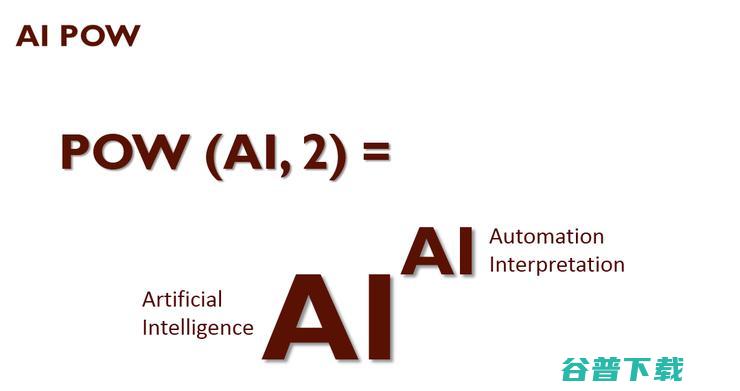

胡侠教授表示,AI要真正落地为人所用,必须要有另外一个“AI”的支撑,其中其中A代表Automation(自动化),I代表Interpreation(可解释性)。

他指出,深度学习的发展给各行各业带来了巨大的便利,但如果解决不了深度学习算法的可解释性问题,它的价值就会大大受限。

比如在用深度学习处理医保骗保问题时,光分析出哪一桩理赔可能存在问题还不够,还必须精准定位出上千页的理赔文件中究竟是哪一页出了问题,这样才能帮助专家快速符合,这就需要算法的可解释性。

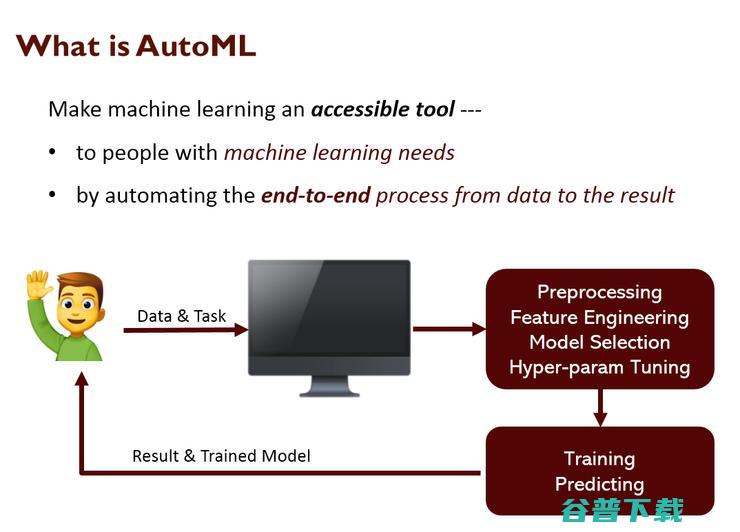

同时,自动机器学习也是行业目前非常热门的方向。它主要有两重价值:一是帮助没有很强数据科学背景的用户更好地利用AI这一工具;二是帮助专业的数据科学家提高效率,毕竟现实生活中千变万化,光靠科学家应付不过来。

以下是胡侠教授的全部演讲内容,雷锋网做了不改变原意的整理与编辑:

深度学习算法的可解释性

报告开始前先给大家讲一个故事。两年前,一位叫Ali Rahimi的谷歌研究员在机器学习顶会NIPS上获得了“Test of Time”论文奖。“Test of Time”论文奖是NIPS为过去十年发表的论文中的最优者颁发的奖项,可以说分量十足。当时,Ali Rahimi在颁奖典礼上发表演讲,将深度学习比作炼金术,指出了这项技术的缺陷

在欧洲历史上,炼金术和占星术一样,都属于神学的范畴。所以Ali Rahimi把深度学习比作炼金术,是一种非常严厉的抨击。

Ali Rahimi抨击深度学习的主要论据是,深度学习算法缺乏可解释性。算法的可解释性为什么如此重要呢?我将用几个行业案例来说明。

先说保险行业。我们跟美国最大的一家保险公司合作,希望用人工智能技术做反欺诈。因为在美国保险业,一些小诊所的医生会联合病人骗保。我们的做法是用人工智能分析某个理赔案例跟其他案例在特征上是否有显著不同,如果有则说明它存在欺诈的风险,我们会将它移交给专家复核。

这件事的难点在于,理赔涉及的文档多达上千页,复核难度非常大。所以我们必须让算法精准定位出究竟是哪一页文档存在问题,这样算法才有意义。

再比如医院场景。假如人工智能系统预测病人得了糖尿病,却说不出依据是什么,病人肯定不会买单,医生也无法对症下药采取措施。

还有自动驾驶。前两年自动驾驶汽车出了不少事故,这是一件很严肃的事情。我们必须对自动驾驶系统进行检查,分析这个软件是怎么写成的,为什么它会在事故发生的瞬间做出错误判断。要回答这些问题,就必须依靠算法的可解释性。

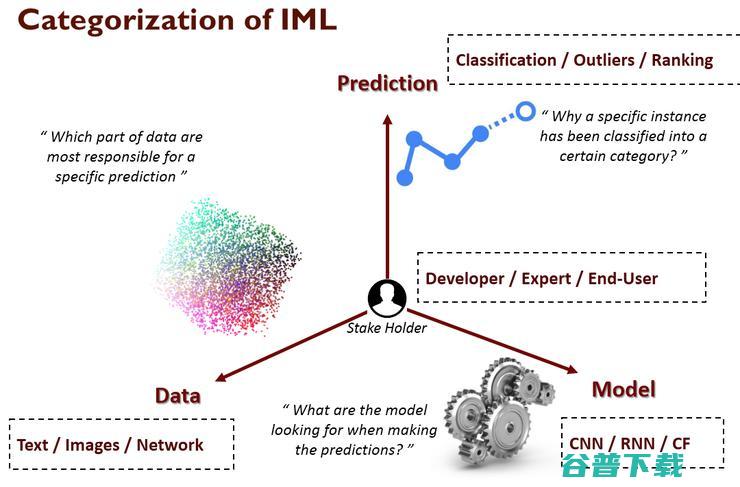

深度学习算法的可解释性非常复杂。因为它的目标(分类、排序)、模型(CNN、RNN、CF)和数据类型(文本数据、图片数据)都很丰富。

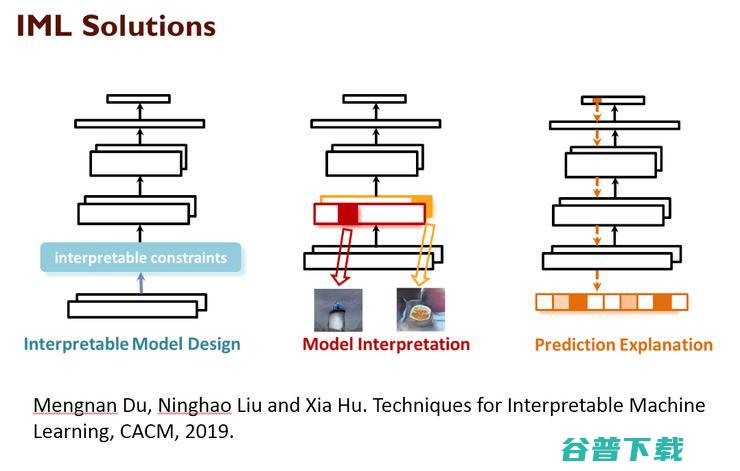

我们在深度学习算法的可解释性方面做了大量工作,总结出了三大解决方向:

一是从模型架构入手。传统的深度学习架构缺乏可解释性,但我们可以对它进行修改,增加可解释性的元素。基于这种方法,你可以根据自身业务灵活调整模型,但它对模型设计能力的要求也比较高,而且每来一个新任务,都需要重新设计模型。

二是重新设计一套验证模型。很多时候我已经有了一个模型,运行效果非常好,那么我就不需要去改动它,而是重新设计一个模型去对它进行验证。比如在医院场景中。医生诊断糖尿病的思路就相当于独立于算法外的验证模型。

三是去解释预测的对象本身。比如一个得了病,我们需要去定义的是他本身,而不是判定他得病的过程。大家有兴趣可以去搜索《Techniques for Interpretable Machine Learning》这篇论文。

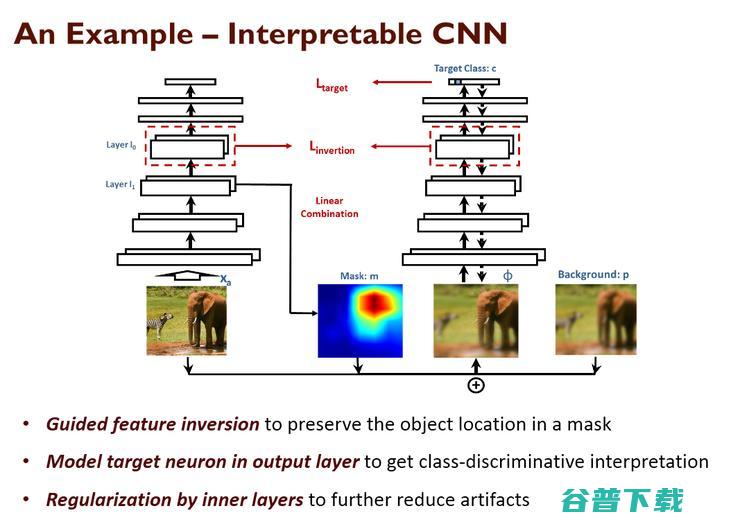

下面举例说明怎么做可解释的CNN模型。下面这张幻灯片的图片里有一头大象和一匹斑马,我们想知道CNN模型是如何运作的,它是根据图片中的哪些部分判断出谁是大象谁是斑马的。

解决这个问题主要有两项挑战:一是怎么找出图片中的重点(大象和斑马),我们很容易就能判断,但机器不是;二是图片中的哪些部分使系统识别了大象或办法。

为了解决这些问题,我们提出了遮罩的办法,即把图片中的某些部分去掉,分析它对系统输出结果产生了多大的影响。比如我们把关于大象部分的图片去掉,对结果影响巨大,这就说明它是图片中非常重要的部分。

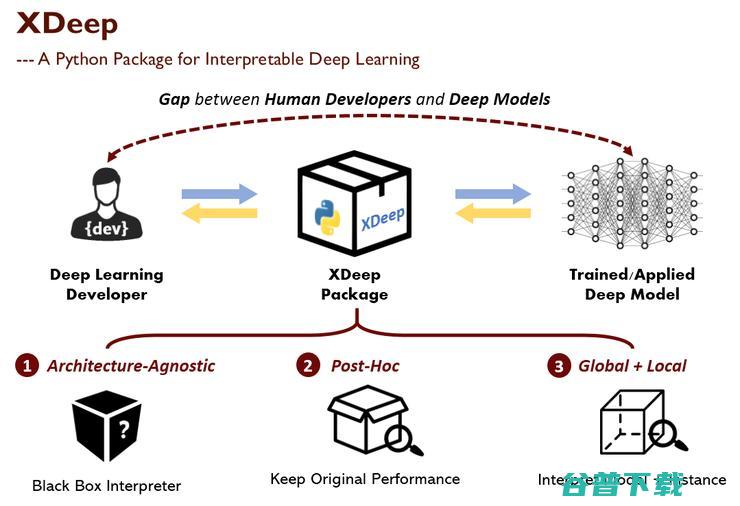

我们很快将推出一个叫做XDeep的软件包,里面包含了目前市场上比较重要的深度学习可解释性方案。我上面提到的三种方案,在里面都有开源代码供大家尝试。

自动机器学习

前面介绍了“人工”的部分,即深度学习可解释性的重要性,下面再讲讲“智能”的部分,即自动机器学习。

自动机器学习是所有大厂都在密切关注的话题,比如谷歌就正在大力推广它的Automated系统。在座很多人都听说过自动机器学习的概念,我简单介绍下它在各个行业的应用。

自动机器学习在金融、医疗、零售等领域都有广泛的应用,它只需要少量数据就能迅速输出结果。虽然结果的准确性可能比不过专业人士,但至少在某些任务上是旗鼓相当的。

自动机器学习一是允许你在某个方向上进行快速尝试;二是可以让你在这个方向有比较好的基础,不必从头开始研究。

比如在零售领域,商品推荐通常有两种做法:一是不分品类,把所有商品混在一起,做一个协同过滤系统;二是针对商品大类做更精细化的推荐。后者的效果显然优于前者,但工作量也更大,有了自动机器学习,问题便迎刃而解。

再比如我们跟LG合作的案例。LG的中央空调中有三个很重要的指标,控制着空调的运行状态,把它们设置在一个合适的值,就能提高空调的能效和使用寿命。但空调的安装位置不同,外界的环境也在不断变化,这三个指标对应的最佳数值也是变化的。我们不可能安排工程师一天到晚守着它,还好自动机器学习可以解决这个问题。现在LG的空调只需要安装好就行,不必人工再去管理了。

通过上面两个案例,我们可以总结出自动机器学习的两大优势:一是能让没有很强数据科学背景的用户更好地利用这一工具;二是可以帮助专业的数据科学家提高效率,毕竟现实生活中千变万化,光靠科学家应付不过来。

当然,如果你的业务提升0.1%的准确率就能带来上亿元收入,那么自动机器学习对你就没有那么重要,因为你完全可以雇全世界最优秀的人来做。

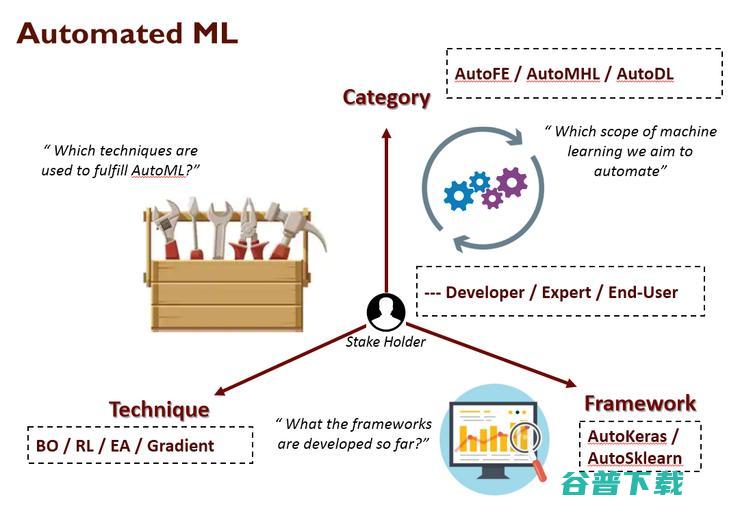

自动机器学习同样可以从类型(AuToFE、AutoMHL、AutoDL)、技术路线(BO、RL、EA)和框架(AutoKeras、AutoSklearn)几个维度来衡量。

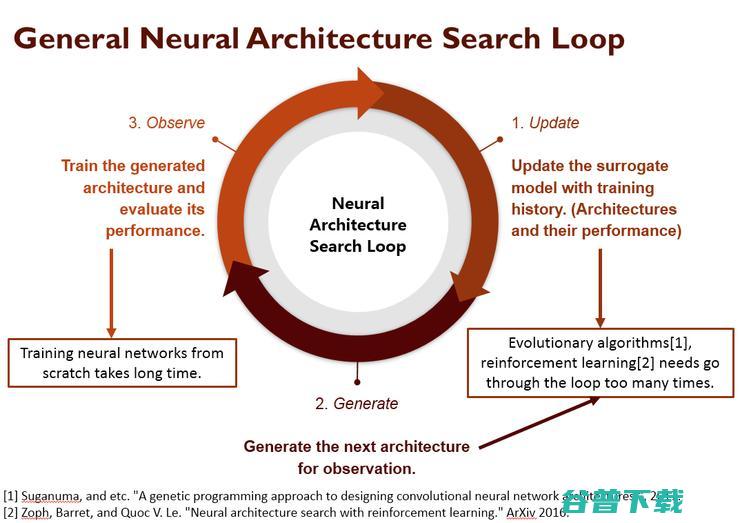

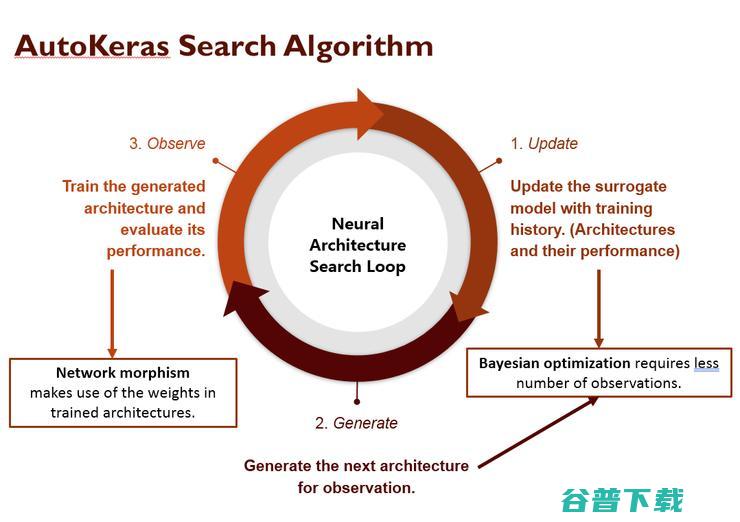

简单介绍下我们是如何实现AutoDL的,主要分三个步骤:

一是用训练中的历史数据更新替代模型。自动深度学习无外乎要解决两个问题:一是确定搜索空间,二是确定搜索方法;也就是在哪搜、怎么搜的问题。现有的方法主要有遗传算法和强化学习,但这两种算法都要多次搜索才能取得比较理想的效果。

二是生成新的架构用于评估。

三是评估新的架构,决定下一步搜哪里,如此循环,不断地去尝试。

我们在这个过程中引入了一项叫做贝叶斯优化的技术,它只需要极少量数据就能取得很好的效果,在药物研发等诸多领域都具备显著优势。

另外,即使我们已经确定了用某个算法,训练的过程还是非常慢;如果能充分利用历史上训练好的模型就能加速这一进程。为此,我们开发了一个叫做Autokeras的自动深度学习系统。

AutoKeras自去年七八月份发布以来广受欢迎,很多人在用。两个月前AutoKeras已经和谷歌Keras团队正式合并,目前正在做基于Keras的优化,很快就有新版本出来。

由于精力有限,我们的首要目标是基于现有的任务做好优化,真正把它应用到企业级的系统当中。同时我们也希望能和大公司合作,开发面向更多任务的应用。

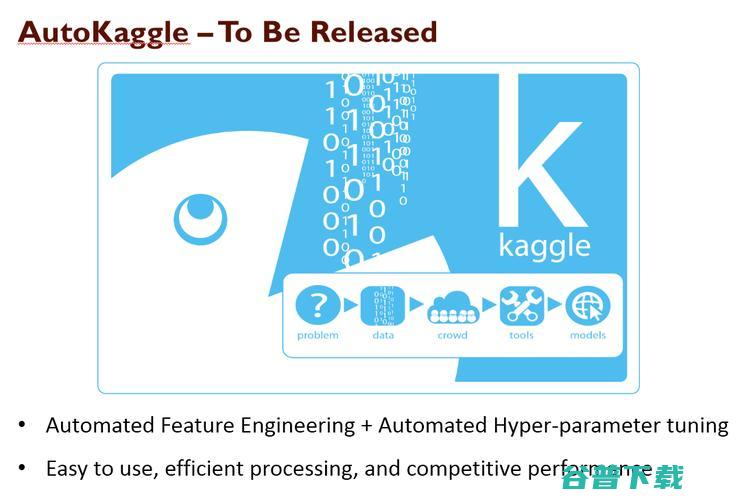

AutoKeras之外我们还做了一个叫做AutoKaggle的软件包。我们做这个软件包是因为Kaggle上有丰富的数据资源,代表了很多现实中的应用场景。

我们希望在AutoKeras的深度学习之外,也尝试做Automated的机器学习,覆盖不同类型和形态的数据。因为我们在实验中发现,深度学习并不是放之四海而皆准的工具,在很多任务中,传统的机器学习算法反而效率更高,效果也更好。

最后我想用下图中的公式来结束今天的演讲。这里我提出了一个AI POW的概念,POW在科学计算中相当于乘方的概念,也就是说AI之上还有一个AI。人工智能要真正落地为人所用,就必须有另外一个AI支撑,其中A代表Automation(自动化),I代表Interpreation(可解释性)。希望在大家的共同努力下,人工智能能在各行各业落地开花。

原创文章,未经授权禁止转载。详情见 转载须知 。

重庆群优朋科技有限公司成立于2023年12月08日,注册地位于重庆市高新区曾家镇曾家大道301号附7号,法定代表人为李兴梅。经营范围包括一般项目:软件开发;网络与信息安全软件开发;信息技术咨询服务;信息系统运行维护服务;信息系统集成服务;技术服务、技术开发、技术咨询、技术交流、技术转让、技术推广;网络技术服务;软件销售;软件外包服务;数字文化创意软件开发;人工智能理论与算法软件开发;人工智能应用软件开发;人工智能基础软件开发;区块链技术相关软件和服务;计算机软硬件及辅助设备批发;动漫游戏开发;数字内容制作服务(不含出版发行);数字技术服务;数字文化创意内容应用服务;平面设计;广告设计、代理;广告制作;广告发布;数据处理和存储支持服务。(除依法须经批准的项目外,凭营业执照依法自主开展经营活动)