贾扬清 MxNet是否英雄落幕 李沐团队半年离开六人 关键能否解决新痛点 (贾扬清新公司)

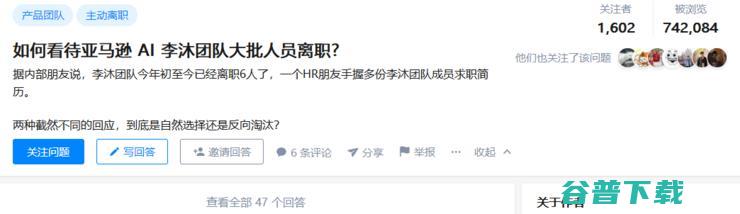

AI 科技评论消息:昨日,据知乎网友爆料,亚马逊AI李沐团队今年初至今已经离开6人了。考虑到李沐团队一共20名正式员工,以及一个研究团队招新的严格要求和团队培养成本,6人离去对于一个团队来说确实是一种重大的人员流失。

在知乎上,有两种回应,一种倾向于自然选择,即类似于末尾淘汰制,对于达不到培养要求的研究人员给予“劝退”,另一种倾向于“精英淘汰”,即学术领域的精英,一些真正德才兼备的精英人才往往会遭冷遇、排挤甚至打击、压制。

由于热度太大,面对大家的猜疑,李沐亲自下场回答,他表示组织人员离开是正常新陈代谢,有的人是因为觉得新项目太挑战,想换个环境;也有的人是因为团队要求开展新项目之前,需要考虑到产品组的实际需求,导致某些人觉得资源使用不自由,所以离开。

最近两个月我们组确实有人离开,在我看来是组织发展下的正常新城代谢。

网友评论:MxNet英雄落幕?

知乎中很多网友,包括前MXNet团队员工也表示,离职其实是因为MXNet这两年的发展比较慢,在PyTorch和TensorFlow的双重夹击下,实现突围非常难。

例如,一位在MXNet项目上贡献commit数量最多的贡献者提到,他从MXNet团队离职的原因是,总体上MXNet ecosystem的蛋糕没有做大,反而是越来越小。

深度学习优秀回答者 mileistone 也对MXNet越来越小的市场份额做出了评价:整个深度学习框架市场几乎被TensorFlow和PyTorch瓜分,MXNet市场低占有率很低。

另一位利益相关的亚麻员工表示,其实在公司内部MXNet用的也很少。

一位自称「野生MXNet“砖”家」的网友提到:MXNet发展的这两三年,书写的很成功,但平台本身仍然没什么大的起色。另外,还细数了MXNet的众多缺点。

最后,一位匿名用户的题外话概括了现在MXNet面临的处境:“沐神辛辛苦苦写的书,本想着推广MXNet,最后一大堆同学放出了PyTorch实现版,着实惨233”。

框架沉浮,MXNet能否实现突围?

2004年,李沐从上海交通大学计算机系 ACM 班毕业。ACM 班作为以培养计算机科学家而闻名的“特色班”,一开始便为李沐的简历奠定了引人关注的基调。2008年。李沐正式从上海交大硕士毕业后,暂时告别了求学生涯,前往香港科技大学任职。

2011年,大学期间就曾在中国IT界的“黄埔军校”实习过的李沐,收到了百度抛给他的橄榄枝。2011 年只2012 年,他在百度担任高级研究员的短短一年多时间里,创建了一套分布式机器学习广告系统,为他的研究生涯又累积了不少工业界经验。

2012年,他的人生轨迹迎来了又一个转变,离开百度前往CMU 深造。当时做出这一选择的背景则是:一方面,在百度的实践经验让他更加认清了自己在研究方面的短板,意识到继续深造会是自己更好的选择;另一方面,他现任妻子当时也被 MIT 录取,也成为了他选择去CMU 学习的一大重要原因。

也就是在CMU,李沐得到了导师机器学习大师 Alex Smola 和 分布式系统教授 Dave Andersen的指导,科研能力迅速提高。在CMU 求学的第二年,正适余凯等人在轰轰烈烈地做深度学习,他也加入这波研究热潮。基于对分布式深度学习框架的兴趣,他选择与陈天奇合作,将CXXNet 作为起点,开始做深度学习相关项目。

一年后,二人合力在Github上创建了一个叫DMLC的组织,随后更是创建了一个与他后续在亚马逊的任职生涯都有着紧密联系的项目——MXNet。

出于对 MXNet未来发展的考量,在毕业后的职业选择上,李沐选择放弃了加入谷歌的机会,而选择去了亚马逊,一直任职至今,展开围绕MXNet的相关项目。

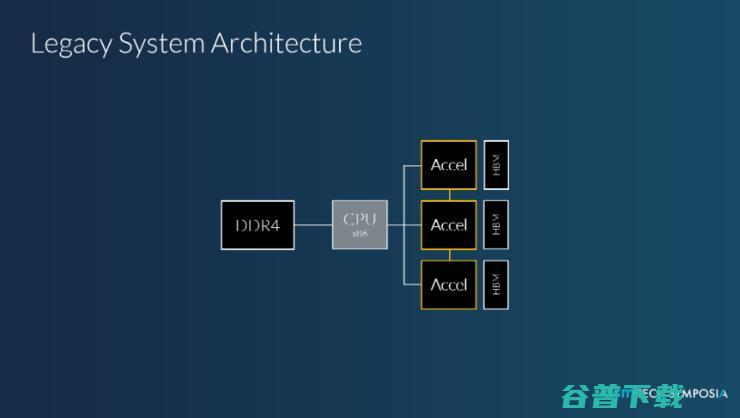

随后MXNet也成为了亚马逊首选的深度学习库,在众多深度学习框架之中,虽然市场份额远不如TensorFlow和PyTorch,但从框架本身而言,MXNet的速度,节省内存,接口灵活性,和分布式效率都是可圈可点的。

MXNet拥有类似于 Theano 和 TensorFlow 的数据流图,为多 GPU 配置提供了良好的配置,有着类似于 Lasagne 和 Blocks 更高级别的模型构建块,并且能在众多硬件上运行(包括手机)。除了对 PyTorch 提供支持,MXNet 也提供了对 R、Julia、C++、Scala、Matlab,和 Javascript 的接口。

也正如李沐之前介绍的那样,MXNet是散修小团体一起合力做出来的平台,排名前20的开发者,基本都是出自不同的门派和世家,这个是MXNet最大的特色。

不论是开始时间还是平台特性,MXNet最靠近TensorFlow。有完整的多语言前端,后端类似编译器,做这种内存和执行优化。应用场景从分布式训练到移动端部署都覆盖。整个系统全部模块化,有极小的编译依赖,非常适合快速开发。

因而发展至今,MXNet 总免不了被拿来和TensorFlow 做比较,对此,李沐曾在AI 科技评论的采访中做出回应:“我很理解大家爱看对比类的文章,但这是种存在偏见的做法。我们比别人快一两倍,不是我们想表达的东西,而为什么快,做了哪些优化,离我们的理想状态还有哪些差距,这样的总结可能对我来说更有价值一些。”

与此同时他也表示,MXNet 与TensorFlow 并不是大家想象中那种剑拔弩张的状态,并且框架的融合会是未来的趋势,系统各自为政的时代会被更多的兼容与支持取代。

而在未来的框架融合潮流中,MXNet 是否还能坚守住自己的一方小小席地呢?我们暂且留下一个问号。正如在李沐团队的这波离职风波中,离职员工本身的“爆料”以及广大热心知乎网友的猜测所言,这么多人离职很大的原因便是 MXNet 这两年的发展比较慢,在PyTorch和TensorFlow的双重夹击下,实现突围非常难。

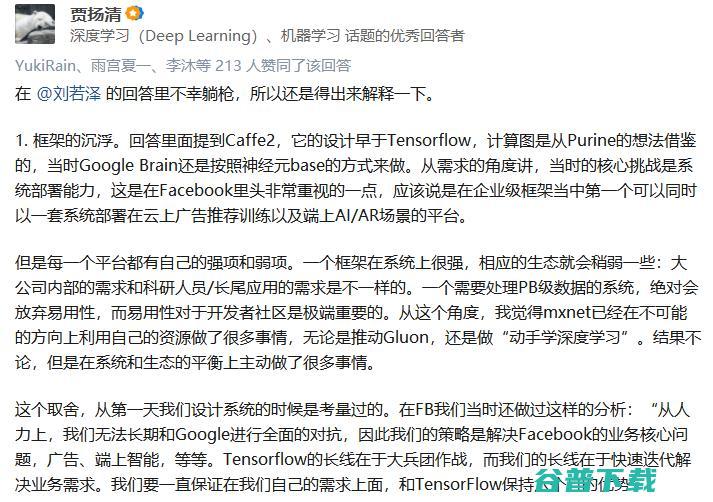

那MXNet有没有突围的办法?曾创建Caffe2的贾扬清表示:框架的沉浮很正常,每一个平台都有自己的强项和弱项。一个框架在系统上很强,相应的生态就会稍弱一些。mxnet的路线如何走,其实和这一堆的机器学习框架的分分合合都有相似性,关键是“我能解决谁的痛点,以及什么痛点”。造轮子不是目的,解决新的痛点才是目的。

(雷锋网)、(雷锋网)、(雷锋网)

原创文章,未经授权禁止转载。详情见 转载须知 。