AI落地的算效彩票和精度盲盒难题 全局智算能解 (ai落地场景)

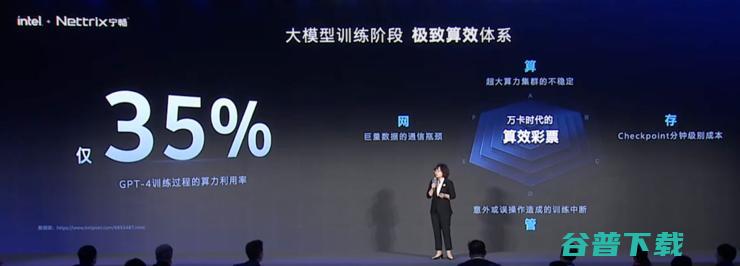

OpenAI训练GPT4算力的利用率大概是35%。

这是业内普遍的水平,对于许多企业而言,提升算力利用率就像中彩票一样难得。

AI训练面临的是算效彩票,AI推理落地面临着精度盲盒问题。

AI想要在垂直场景落地,模型的精度要达到95%以上,但因为各种因素的影响,实际落地时的精度就像是开盲盒一样。

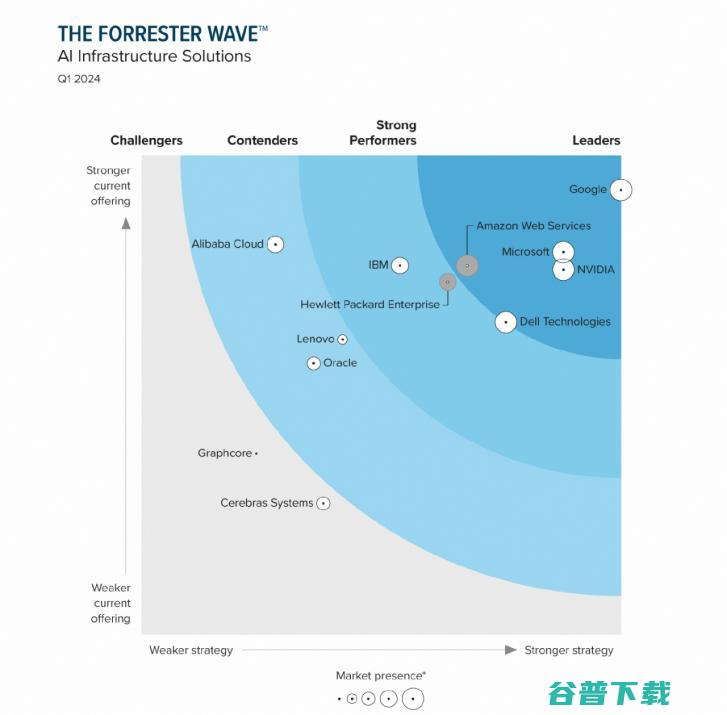

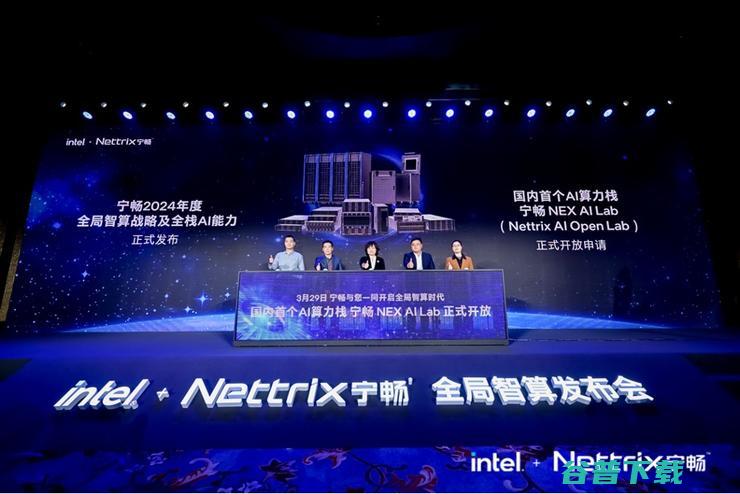

“大模型发展落地过程中,面临的万卡时代的算效彩票,深入行业的精度盲盒,以及高效调用的服务瓶颈,愈发需要系统性AI计算方案提供全方位、全周期支持。”宁畅总裁秦晓宁在2024年度战略发布会上宣布了全局智算的战略及新品。

秦晓宁介绍,宁畅的全局智算具备六大全特性, 涵盖软硬件全体系及全液冷产品,提供从咨询到运维的全流程服务,满足全行业用户大模型开发、适配、部署的全场景需求,并按用户发展阶段,定制专业且性价比高的AI计算方案。

如今的全局智算战略,离不开宁畅成立之初义无反顾地研发当时不火的AI服务器。

从买更多服务器的百模大战,到需要软硬一体方案的商业化落地

去年最疯狂的时候,国内每隔一天就会有一个AI大模型出现。

在这个百模大战的时期,大模型公司的第一要务是购买更多更快更强的算力,也就是买更多GPU服务器。

当服务器集群数量达到万卡甚至十万卡,算力的净增长和服务器数量的增加不再是线性关系,需要从软件、算法以及整体的优化解决低算力利用率的问题。

“2024年,大模型从参数的竞赛走向了商业化、产业化的落地阶段。”秦晓宁说 ,“这个阶段不仅要提供算力硬件,大需要在算力、算法、数据三个维度来提供更需要更强的支撑。”

大模型的落地需要考虑的因素更加复杂,包括安全性、部署速度,稳定性等。

安全性关乎所有AI落地的场景,因为数据涉及到内部信息、客户数据等,这些数据高度敏感,需要考虑数据的安全合规性,只有做好高质量数据的治理、清洗、标注等一些列工作,才能让大模型在具体场景中落地时不是开盲盒。

保证安全的前提下,部署时间也非常关键。调查数据显示, 超过64%的企业部署AI应用的时间周期是90天甚至更长。 想要加速AI的落地,需要解决训练和推理之间团硬件数据无缝实时对接的问题,还需解决部署阶段的冗余等问题。

实际应用的阶段,稳定性非常关键,这要求有一个稳定的运行环境,同时对健康能耗状态全面的监管。

显然,应对大模型对算力的需求既不是简单的硬件堆叠,也不是单纯的硬件能力就能解决,需要的是软硬件的全栈能力。

所以宁畅推出全局智算战略。

“原来我们更多的精力是放在基础硬件架构上,是在某一个点上加深专业度,现在我们下定决心,要把所有东西整合在一起 ,这对宁畅的要求更高。”秦晓宁说,“但是我们可能给客户、最终行业带来的改变更大。”

全局智计算如何提升AI的算效和精度?

宁畅最新推出的全局智算战略,包含了六个层面。

最底层的硬件资源层,有通用的服务器、GPU、整机柜、存储、网络多种形态的产品。

“硬件层上面的 集群设计层,不是将海量硬件简单连接堆叠就能服务客户的场景。 宁畅会分析整个业务运行的特征和系统的量化需求,提供从微架构、网络、存储、AI模型特征等一系列的方案化的设计。”秦晓宁介绍。

再上一层是算子优化层,宁畅提供了AI算子自由化能力,目的是为了减少模型执行时间,降低资源消耗。

算子优化层之上是AI中台层,全面支持NVIDIA AI Enterprise(NVAIE),也有宁畅自己的中台NAIOM,可以提供基于AI算力系统深度整合的工作栈。

在AI中台层之上就是业务层和场景层。

宁畅CTO赵雷介绍,“我们的全局智算,包含的是硬实力(硬件)、软动力(软件)、服务力(服务)三部分,剩下的三部分是通过这三个能力实现。”

硬件一直以来都是宁畅擅长并且专业的部分,也是全局智算的硬实力,具体体现在可实现多种交付形态灵活组合。

其中,宁畅B8000液冷整机柜服务器作为AI算力栈最具亮点的交付形态,采用电、液、网三路全盲插设计,部署周期相较传统方式提升30倍。

在全局智算的软件层面,基于系统工程及算法模型,以AI算子全栈优化能力,为AI业务提供并行加速、性能分析、模型开发优化等服务支持,构建出从算力资源定制,到模型适配优化,再到高效部署落地的大模型算力服务闭环,帮助用户极速推进AI应用开发及管理。

“与以往不同,我们为什么要做软件?”赵雷分享, “我们需要计算能力分析,找到算力的缺口;也需要找到网络拥堵的地方升级网络;还需要根据AI应用,让机器的负载时最好的选择。这些都需要软件才能进一步提升AI的运算能力和产品使用率。”

了解到,宁畅的AI软件栈,是业内相对标准化的软件栈,结合了实际的案例和思考。

国内首个AI算力栈加速AI落地

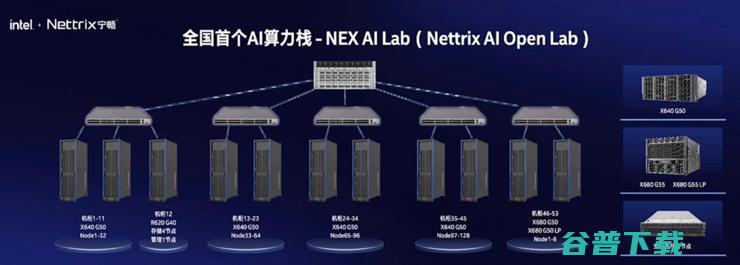

发布全局智算战略的同时,宁畅也推出了战略性新品AI算力栈——NEX AI Lab(Nettrix AI Open Lab),作为国内首个AI算力栈,已在桐乡市成功落地,目的是解决大模型产业落地的全周期问题。

NEX AI Lab是一个128台GPU服务器组成的算力集群,同时使用了三种设备,集成加速计算节点、全闪存存储节点,可为GPT、LLaMA、Stable Diffusion等AI模型,提供多元场景应用优化支持。

NEX AI Lab已经运行了三周,证明了宁畅具备从硬件到软件的全栈平台服务能力。同时, NEX AI Lab可以提供免费的算力。

如果说从2020年4月份开始研发AI服务器时的忐忑, 到2023年吃到AI服务器红利,宁畅是押对了方向。

那么 宁畅在2024年生成式AI落地的重要时刻推出全局智算战略,就是抓住了乘风而上的时代机遇。

原创文章,未经授权禁止转载。详情见 转载须知 。