人工智能的多模态发展丨CCF 腾讯贾佳亚 (人工智能的多模态技术)

7月12日-7月14日,2019第四届全球人工智能与机器人峰会(CCF-GAIR 2019)于深圳正式召开。峰会由中国计算机学会(CCF)主办,雷锋网、香港中文大学(深圳)承办,深圳市人工智能与机器人研究院协办,得到了深圳市政府的大力指导,是国内人工智能和机器人学术界、工业界及投资界三大领域的顶级交流博览盛会,旨在打造国内人工智能领域极具实力的跨界交流合作平台。

7月14日下午,在 「智慧城市·视觉智能」 专场上,腾讯优图实验室联合负责人,腾讯杰出科学家,香港中文大学终身教授贾佳亚作为开场嘉宾,率先分享。

贾佳亚教授在香港科技大学获得计算机科学博士学位,在微软亚洲研究院做一年半访问学者后,2004年加入香港中文大学计算机科学与工程系,2010年升任副教授,2015年任教授。

贾佳亚教授任职期间发表过逾百篇顶级会议和刊物论文,是前期和中期计算机视觉最著名的专家之一,研究方向为计算机视觉、图像计算和处理、机器学习等,最广为人知的成果是图像去模糊算法,以及去年带队在ImageNet比赛中拿下了Scene Parsing(语义分割)的冠军。

雷锋网了解,贾佳亚教授还多次担任ICCV(国际计算机视觉大会)、IEEE CVPR(国际计算机视觉与模式识别)的领域主席,以及2013到2017年ICCP(国际计算机影像会议)和SIGGRAPH(计算机图形和交互顶级会议)的论文委员会成员。

甫一亮相,他便提出了一个终极命题,“人工智能的终极应用距离我们到底还有多久?” 他给出的答案是:可能还需要50-100年的发展路径。

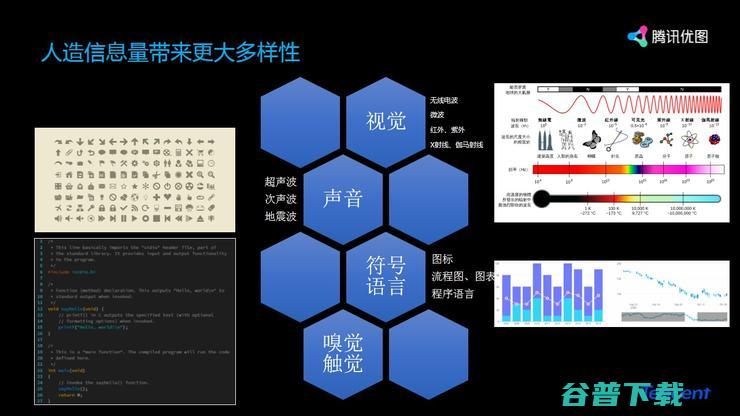

贾佳亚教授认为,人工智能学科发展与人类智能差距之一就是“多模态信息的智能化理解”,视觉、声音、符号语言、嗅觉和触觉等信息,具有无限多样性。

而多模态人工智能还存在不少技术难点:第一是数据模态多种多样,包括2D图像、3D模型、结构化信息、文本、声音及更多无法量化的数据;

第二是多模态数据的不对应,如从图像到文字,从文字到图像,都是“一对多”的过程,会有多种的描述和呈现;

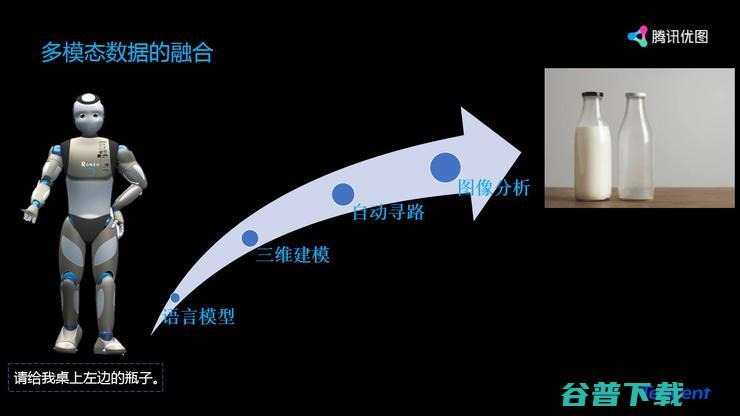

第三是多模态数据的融合,一个软件或算法的进步较为容易,但多个算法叠加在一起,难度将几何级上升,如“告诉机器人拿桌子左边的瓶子”,会经过语言模型、三维建模、自动寻路、图像分析等步骤;

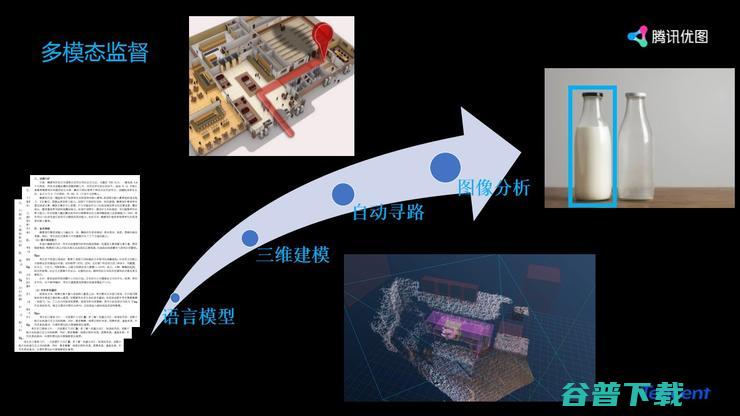

第四是多模态监督,“如何告诉机器人拿错了”“哪一个步骤拿错了”也是目前的难点。

而要解决这些多模态信息的难题,贾佳亚教授提出要更好研究嗅觉、味觉、触觉、心理学等难以量化的信号问题,通过多模态数据使得计算成为可能,进行协同学习、用一个资源丰富的模态信息辅助另一个资源贫瘠的模态。

多模态人工智能问题的解决,就会是人工智能更多落地的未来。

以下是贾佳亚教授大会现场全部演讲内容,雷锋网作了不改变原意的整理及编辑:

大家好,今天来到这里非常开心,因为近期工作繁忙,较少出席外部大会,现在恰逢暑假期间,可能各位同学或者科研爱好者希望外出学学东西,我也在想,CCF-GAIR可能会是一个比较好的机会。

今天我会向大家展示一些新方向的研究。首先给大家抛点砖以引玉,看看人工智能领域学科发展的现状。

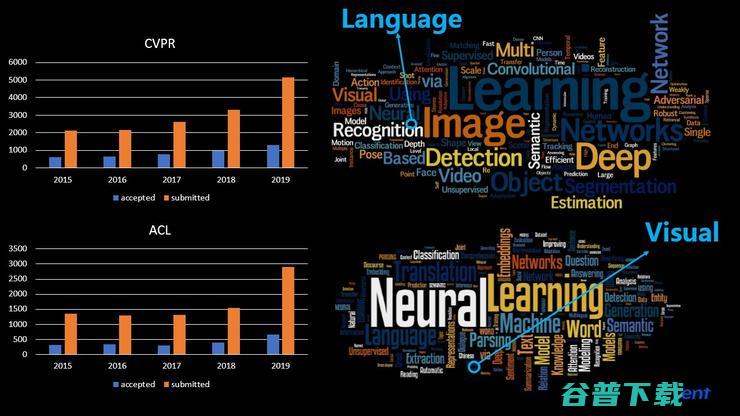

每年如此多优秀论文的出现,也就意味着人工智能的发展还处于一个快速上升的阶段。

这是它们的趋势,是比较表面的东西,我们来看更深层次的东西。

上图还有CVPR的关键词,包含Deep、Image等等,今天我给大家讲的不是这些很热门的方向,其中还有一个大家很容易忽视的模块:Language。

再往下,ACL最热门的是Deural、Learning等等,这里面也有一个非常小的领域:Visual。

这两个领域基本上是分割开的,通过对于这些关键词的分析,可以发现虽然都是AI的顶会,大家都做了很多有趣的工作,但是里面的内容基本没有交集,懂ACL的人并不懂CVPR,懂CVPR的人也很少在ACL里面工作。

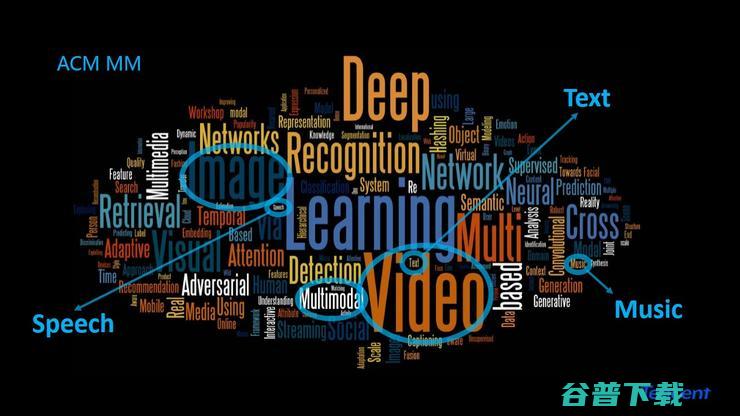

ACM MM是一个比较综合的大会,里面有更多的交叉性学科,但是其中最重要的部分依然是Video、Deep等等;非常小的部分是Text、Speech。

我们通过对它的研究,挖掘出一些不会引人注意的特征。为什么去挖掘它?因为这件事情是跟我们对传统的AI认知恰恰相反的事情。

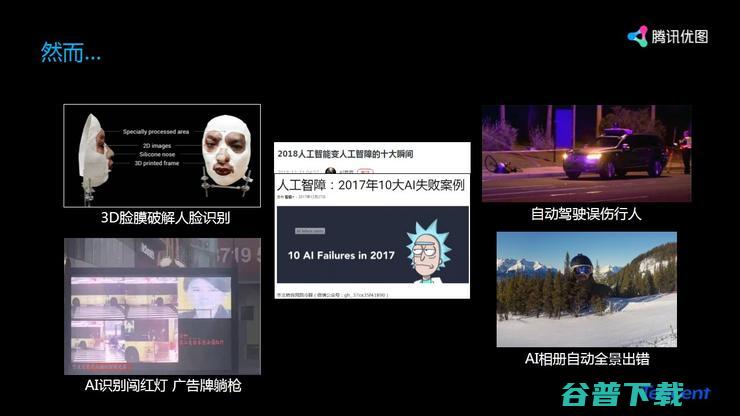

在传统的AI认知中,我们认为AI已经做得非常好了。

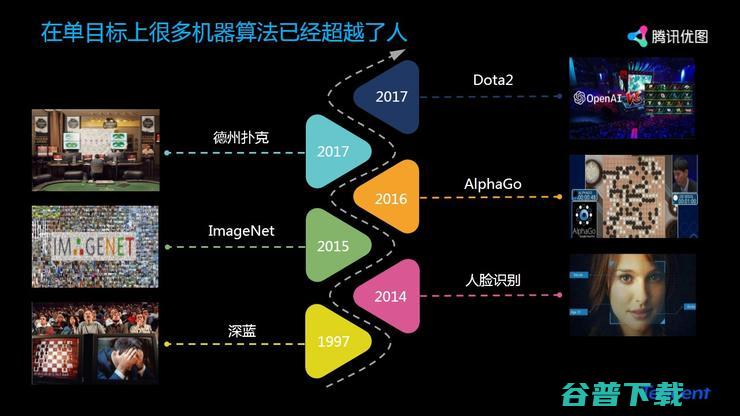

从1997年的深蓝,到2014年人脸识别的突飞猛进,所谓的AI发展,其实都是在某一个子领域做到极致。

今天我将这个部分作为开头,更想给大家讲的是,AI再往下发展应该怎么走?这也是之前很多人问过我的问题。

我的基本观点是: 现在的AI距离终极的应用和最后的发展还很远很远,我相信接下来的AI发展道路不止10年、20年,可能是50到100年的发展路径。

首先我认为人工智能学科的发展与人类的智能差距还非常、非常之大。

人工智能和人类智能差距的一个重要原因是对多模态信息的智能化理解,这是各位投身学术界或产业界需要重点关注的一个领域。

从大脑结构可以发现,我们所有的感知系统是一体的,这个大脑既包括了听觉、味觉、嗅觉、触觉,也包括了说话、行动、感应、压力控制。

人脑就像一个中央控制系统,能够把所有的感知系统全部融合起来,如果与人脑做对比,现在的人工智能发展还处在一个非常弱小的阶段。

因为我们现在还没有一套完整系统,甚至没有一个好的算法,把最为简单的两种模式叠加起来。

如果十年、二十年后回过头来看我们现在的发展历程,比如人脸识别超过了人、特征识别超过了人,这些都是微不足道的,因为我们有更为广阔的天地要去探索。

通过以上介绍就会发现,其实人工智能距离成熟还太远太远,现在的人工智能是单模态的人工智能,甚至是单点的一个触发,在以后的多模态世界中,会发生很多更为有趣的事情。

同时,做好这件事,也有诸多难点。

第一个是数据模态的多样性。

我们有这么多图像、模型、文本、声音、结构化信息,怎么去融合?怎么能找到一个场景把这么多信息融合进来?

当你把这些信息全部融合在一起的时候,与我们最为贴合的是哪一个产业?那就是汽车产业。

不管是车与车之间的交流,还是车与道路之间的交流,其实车更像一个机器人,而且在不久的将来,我相信随着车厂和各个技术的融合,这个行业会产生非常多有趣的应用。

除此之外,多模态还有很多无法量化的数据,比如说嗅觉现在还没法去量化,比如闻到一个香味,到底怎么量化它?

第二个难点是多模态数据的不对应。

举一个简单的例子,假设人们看到上面这张图的时候,其实我们有非常多的方法去形容。

但是当我们用多模态数据表述的时候,如何能把两种不相关的数据完整地、像人一样自然地表达出来,这是非常难的事情。

第三是多模态数据的融合。

我一直说一个软件或者是算法的进步是很容易的,但是多个算法连在一起,它的难度是几何级上升的。

现在很多机器人可以跳舞、可以交互,但还没有一个厂商能在五年内完成一个指令:去帮我拿桌子上左边的瓶子。

这其中就涉及到语言模型、三维建模、自动寻路、图像分析、反馈机制,这样一个简单的工作,现在还难以驾驭。

优图实验室借助强大的腾讯平台,我们过去在这方面也做了一些有趣的探索。

这是一个小视频,如果谁能看得懂他表达的意思可以举手示意一下。

在场几百位听众,没有一个人知道他在表述什么事情,其实我也不知道。

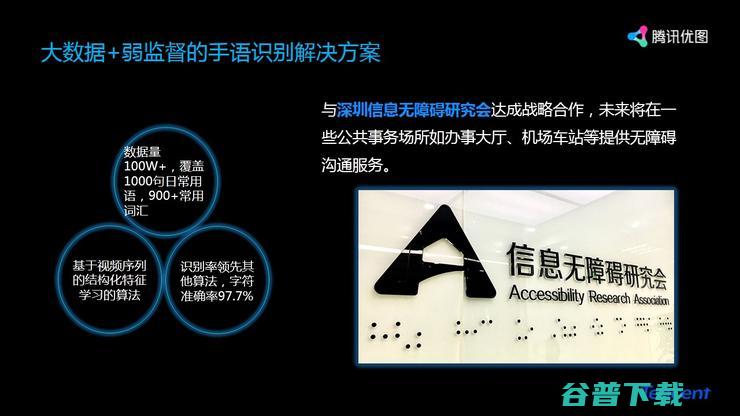

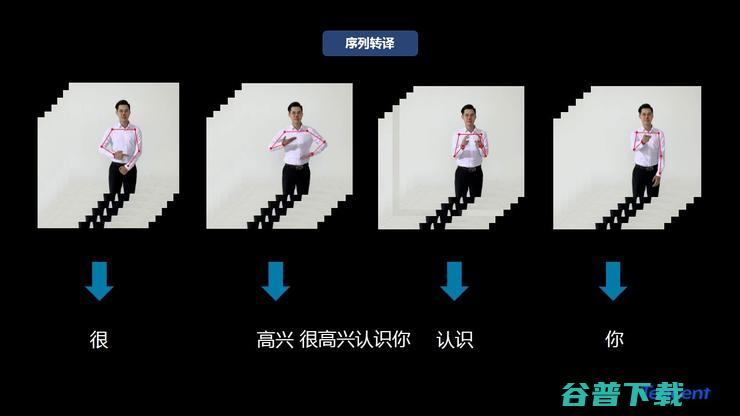

基于此,我们在已有的一套非常好的骨骼系统上,加了一个解决手语人士和正常人士交流沟通的翻译器。

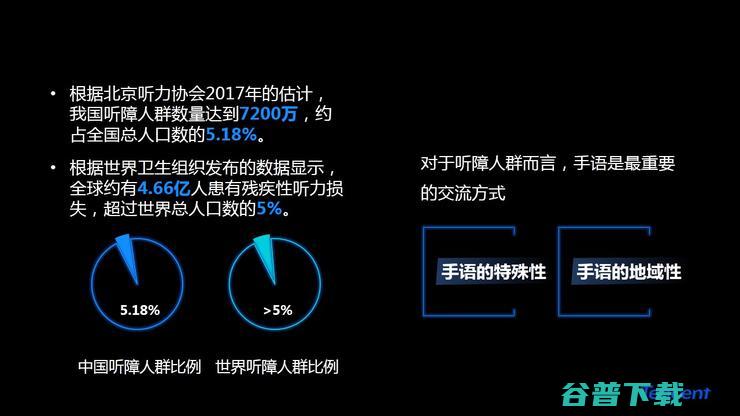

做这件事之前,我们做了一个调研,发现我国有听障人士7200万,占全国总人口的5%;全世界有超过4.66亿人患有残疾性的听力损失,占了全球人口的5%。

这件事对我的触动很大,由此,优图实验室在过去几个月就投入了部分研发人员做这件事情。

我们希望做一个手语翻译器,能够很好解决听障人士的交流问题。这件事情看起来很简单,但做的过程中却困难重重。

首先,中国现在都还没有一套规范的手语标准,深圳的手语和北京的手语是不一样的,东莞的手语可能和深圳的也不一样。

当时我们想当然地认为这件事情很容易做,用一套强一点的算法可以在三个月时间内做出来。

事实并非这样,除了刚才的问题之外,还有一个非常难的问题,数据采集回来后,如何将数据转化为应用。

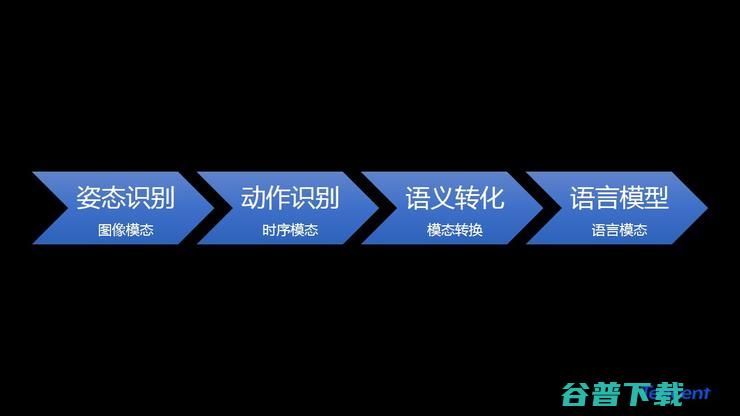

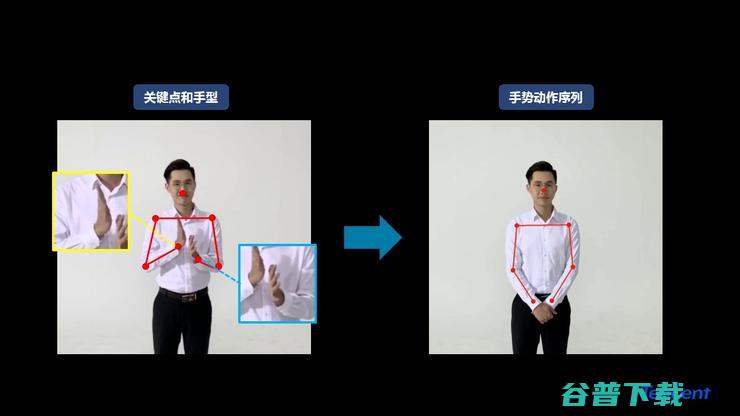

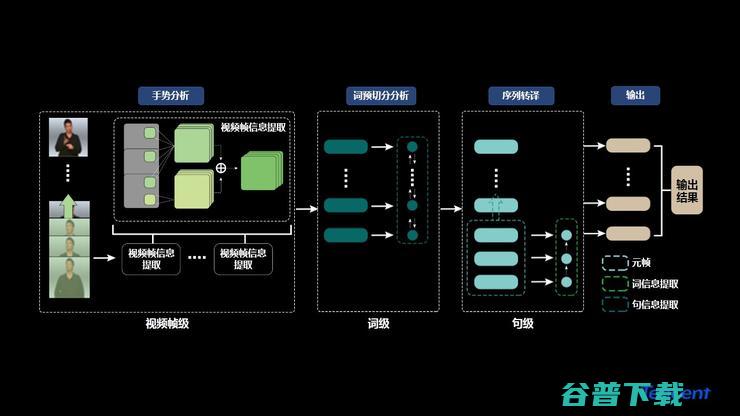

首先需要做一个姿态识别,它是一个图像模态;然后做动作识别,是一个时序模态;然后做语义转化,最后做语言模型,这是一个大致的流程。

在这个过程中,我们需要提取到关键点和手型,然后转化为文字,最后全部粘合起来变成一个语言级的表述,这是一个非常大的系统,我们最后做下来,远远超过了当时预估的工程量和算法技术含量。

目前,我们还只是在一些关键的语句上做得比较好,当我们把这些语料库提供给政府、学校使用的时候,可能还需要一个多月甚至更长的时间去开发。

语言和图像联合处理方面,给一张图片,问一个问题,机器能够回答的也是寥寥可数,包括我们现在能做到的也是非常简单的,稍微复杂一点的都做不了。

比如说上图中,问这个花是什么颜色?它会回答我这是黄色。

同样一张图,问花是放在哪里的?你要得到“花瓶里”的信息,它会告诉你这是一个花瓶。这里面涉及到对图像的细粒度理解,也涉及到自然语言的融合和解答过程。

这是我们当时设计的一个模型来做这件事情。

我们回头来看,多模态还有什么问题? 第一是数据集存在巨大的Bias, 比如看到这张图象,绝大部分人问的问题都是,这是不是长颈鹿,绝大部分的答案都是“是的”。

但是很少人问,这张图像里是不是个羚羊,没有问这些问题的时候,系统就学不到否定性的答案,在你的数据集上就会出现很大的偏差。

第二是这个问题缺乏多模态的监管 ,也就是说有这样一个图像,我们只有一个简单的问题,比如 “这里面的桌子是什么颜色的”,实际上图片中并没有桌子,但它还是要给你一个答案,这就是缺乏监督的原因。

还比如说,这张图像里有多个人员,我要把它区分出来是非常难的,人眼可以精确分割碗里的每一粒米,但是现在的算法想分割出每一粒米,并不是很容易。

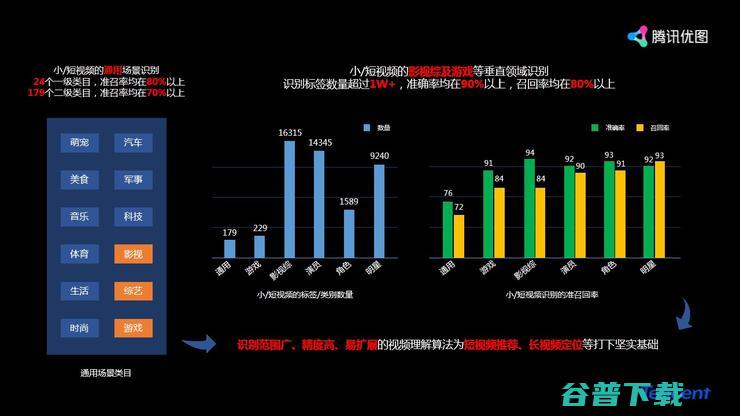

基于腾讯的一个巨大的内容平台,我们每天要处理百亿计的视频,包括长视频、短视频、小视频。

我们基于多模态的处理方式,从视频本身得到很多视频特征,然后进行多模态融合,目前做得效果不错。

最后讲讲多模态的未来发展。

多模态要解决非常多的难以量化的信号,包括嗅觉、味觉、触觉等等。

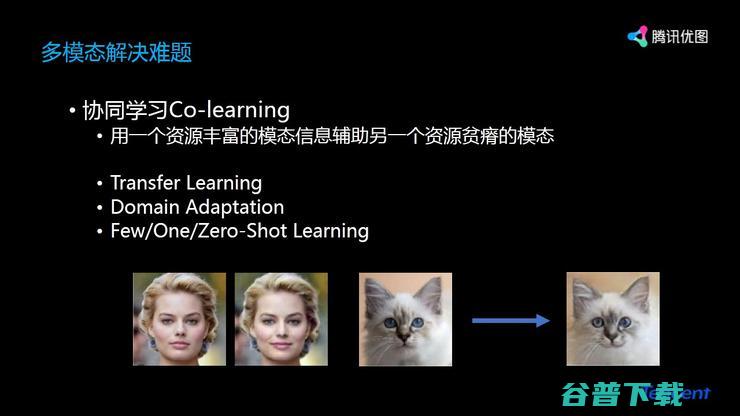

再往下走,多模态还要解决非常多的协同学习问题,用一个资源丰富的模态信息辅助另外一个资源贫瘠的模态,这里面就涉及到更多的机器学习的内容,包括Transfer Learning、Domain Adaptation、Few/One/Zero-Shot Learning这些非常基础而且非常重要的机器学习内容。

这是我们今年在做的一件事情,当我们看到两张人脸的时候,我们想把它们之间的变化转移到猫身上,这就是一个非常典型的Domain Adaptation。我们把两个人脸转化成猫的表情,这是用一种模态指导另一种模态做更有趣的事情的其中一个案例。

最后的结语:现在的人工智能已经非常厉害,尤其是在CVPR、ICCV和ACL等等顶会上看到很多了不起的方法出现,在每一个子项上不断地刷新记录,推动这个技术空前发展。

但是如果问我,当把所有的记录都刷完了,是不是意味着技术发展已经到达瓶颈?我告诉大家,这个记录是永远刷不完的,人可以做到的事情是机器远远达不到的。

每个时代都会成为过去的时代, 在这个过程中,我希望大家能够继续保持对这个领域的热情,并做出更多成绩。

谢谢大家。

贾佳亚教授: 有很多的事情。

比如我们AI Lab做了一些虚拟人,我们希望以后的游戏直播、解说能够由虚拟人代替,能够达到比较有趣、流利的直播效果。

我们应该也是在整个行业里面最早做瘦身、长腿效果的平台之一。

我们不仅仅希望用技术推动企业往前发展,我们还是希望科技能够向善,推动社会前行,希望技术可以帮到任何一个弱小群众,让他们能够正常与人交流、看到世界。

现场观众提问:听到您讲到一些应用,然后说到科技向善,如何让技术真的做到科技向善,而不会变成一种毁灭人类的武器?

贾佳亚教授: 这是一个很好的问题。

我以前在很多演讲中,第一句话就会说,科技产品无所谓向善还是向恶,科技永远是中性的。

科技可以制药,挽救生命;可以造芯片,改善生活,这些都是向善的。为什么今天又要提出这个概念?是因为大家发现当一项技术不仔细规管的时候,或者被别有用心的人利用之后,就能利用其去做一些不利于社会和谐的事情。

所以科技向善需要国家监管、法律健全,还要引入更多专家,推动立法、隐私保护、道德管理。未来,我们也会在这个层面投入更多的人力、物力。

至于毁灭人类,这个事情太过长远,可以暂且不讨论。

原创文章,未经授权禁止转载。详情见 转载须知 。