ECCV 2022 (eccv2024 best paper)

ECCV 是计算机视觉领域世界三大顶级会议(CVPR,ICCV,ECCV)之一,每两年举办一次。ECCV 的论文投稿量近五年来持续增长,根据ECCV 官方网站数据,2022年ECCV 收到有效投稿论文8170篇,评审通过接收1629篇,评审不通过拒稿6541篇,接收率不到20%,反映出AI视觉技术在工业界和学术界的创新热情继续高涨,但创新难度也在不断加大。作为对比,2020年ECCV共收到有效投稿5025篇,接收论文1361篇,接收率为27%。2018年共有2439篇投稿,接收776篇,录用率为31.8%。通过对比发现,ECCV 2022论文接收投稿数直接拉满,比2020年还要多大约3000多篇。而录用的论文这次比ECCV 2020仅多出200多篇,很显然,中稿率下降也是情理之中。除了我们熟知的CVPR、ICCV,ECCV(欧洲计算机视觉国际会议)也是计算机视觉三大国际顶级会议之一,每两年举办一次。ECCV 2022 将在10月23日-27日的以色列特拉维夫(Tel-Aviv)举行。和刚刚过去的CVPR同样,这个会议也将采取线下和线上混合形式召开。

论文解读:

论文概述:

l本论文中提出的基于原型的分类器学习方法结合了目标检测框架,适用于智能物品集合视觉检出识别场景。

l该方法可以减少实际应用场景中对人工的依赖,加快物品集合检出识别流程,并且能够提高视觉检出识别准确率。

l由于物品集合单品示例与检出识别图像间存在领域差距,单品示例中只有单个物品集合,而检出识别图像中是多个多类物品集合的任意组合,这是物品集合视觉检出识别任务的一个主要挑战。

l本文提出的通过物品集合单品示例进行基于原型的分类器学习方法,在目前规模最大的物品集合视觉检出识别数据集上的结果明显优于现有先进方法。

创新背景:

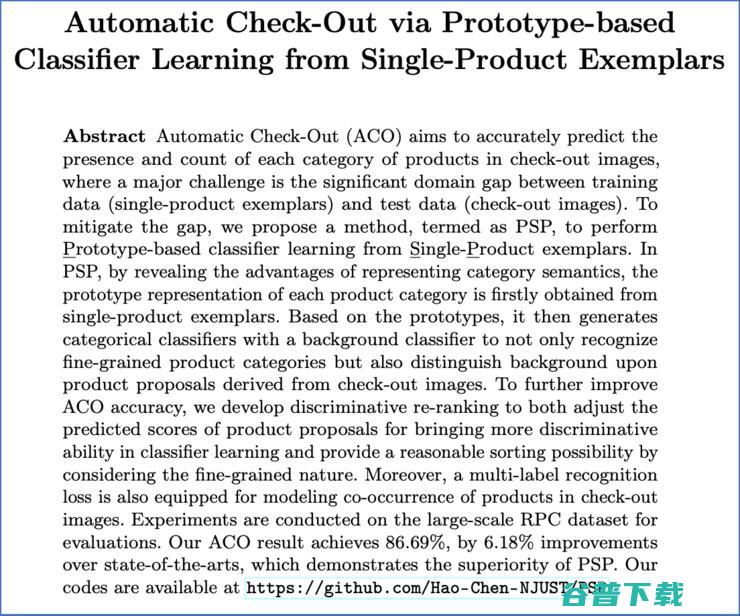

物品集合视觉检出识别任务旨在对物品进行精确的检出与识别,包括识别每一类物品是否存在及其数量。该任务的一个主要挑战是训练数据(单品示例)与测试数据(检出识别图像)间存在的巨大领域差距。

为了缩小这种差距,本文提出了通过单品示例进行基于原型的分类器学习方法。通过揭示表征类别语义的优势,首先从单品示例中获取每个物品集合类别的原型表示。在原型的基础上,生成包含背景类别的分类器,不仅可以识别细粒度的物品类别,还可以区分来自检出识别图像的背景候选框。此外,本文还通过对物品候选框分类置信度分数的鉴别性重排和全局层面的多标签损失,来提升模型性能。

主要贡献:

1.提出了基于原型的分类器学习方法,用于处理物品集合视觉检出识别任务,特别是缓解领域差距问题。

2.设计了一个鉴别性的物品候选框分类置信度分数重排方法,从而增强基于原型的分类器的鉴别能力。

3.基于目前最大规模的物品集合视觉检出识别数据集进行实验,本文模型在整单物品集合的检出识别准确率上明显优于现有的解决方案。

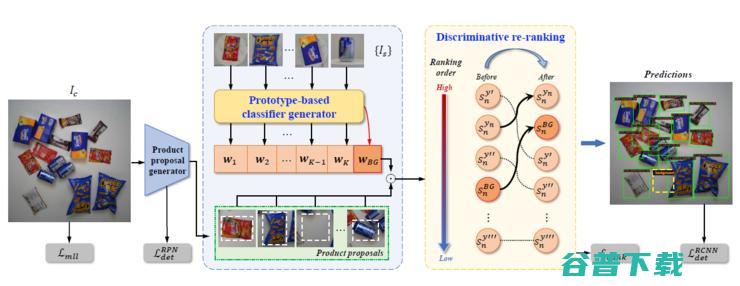

这是一种针对物品集合视觉检出识别的基于原型的分类器学习方法,结合了二阶段目标检测网络,包括以下步骤:

步骤1:由一个预训练的网络提取单品示例的特征并得到各类以及背景类原型,通过一个基于原型的分类器生成器生成包含背景类的物品候选框分类器。

步骤2:物品集合的检出识别图像输入二阶段目标检测网络,由区域候选网络生成物品候选框,使用步骤1生成的物品候选框分类器对这些物品候选框进行分类。

步骤3:根据步骤2得到物品候选框分类置信度分数,对此进行基于背景类别的鉴别性重排,有利于对细粒度类别分类,同时提高了分类器的鉴别能力;另外,使用多实例损失对检出识别图像中各类物品的共现关系进行建模。

本方法与现有技术相比,其显著优点为:

(1)本文方法使用基于原型的分类器学习方法,对单品示例与检出识别图像间存在的领域差距进行了弥合,提供了一种不同于现有方法路径。

(2)本文提出了基于背景类别的鉴别性重排方法,针对语义相近的细粒度物品集合类别进行分类。

(3)与现有方法相比,本文方法性能更佳且所需计算资源更少。

创新奇智CTO张发恩(本论文作者之一)指出:“创新奇智提出的通过单品示例进行基于原型的分类器学习方法,可以减少实际应用场景中对人工的依赖,加快物品集合检出识别流程,并且能够提高视觉检出识别准确率。由于物品集合单品示例与检出识别图像间存在领域差距,单品示例中只有单个物品集合,而检出识别图像中是多个多类物品集合的任意组合,这是物品集合视觉检出识别任务的一个主要挑战。本文提出的通过物品集合单品示例进行基于原型的分类器学习方法,在目前规模最大的物品集合视觉检出识别数据集上的结果明显优于现有先进方法。”

制造业的物品检测需求量多而复杂。传统的方式不仅耗时耗力,而且检测准确率不高。创新奇智提出的通过单品示例实现对物品集合的检测,非常适用于诸如汽车零部件、消费电子设备等有批量产品检测需求的场景,不仅能够加快检测流程,而且能提升检测准确率,为企业降本增效带来直接助益。

版权文章,未经授权禁止转载。详情见 转载须知 。