何为 负责任且可评估的AI 商汤发布AI治理白皮书诠释 落地为王 (负责任是什么)

一年一度的AI产业盛会——世界人工智能大会刚刚落下帷幕。据不完全统计,三天会期间,有10余场围绕AI伦理、可持续发展相关的主题论坛。其中,近半数,都涉及可信AI,如何落实为AI立信、为技术立规,成为既原则与政策之后,新的伦理热点话题。

本届WAIC上,商汤正式发布《“平衡发展”的人工智能治理白皮书——商汤人工智能伦理与治理年度报告(2022年)》深入探讨并分享了商汤在推动AI治理落地进程中的洞察、思考、目标与实践。

今年以来,新加坡、欧盟、美国、中国等国家的监管机构和第三方机构纷纷发布AI治理测试工具箱、技术监管沙箱,推进AI治理的落地实施。报告指出,当前,人工智能治理已经进入了以技术验证为主的落地实践阶段。

商汤高度重视人工智能治理,去年就提出了“平衡发展”的人工智能伦理观,同时明确了“以人为本、技术可控、可持续发展”的伦理原则。随着人工智能治理进入落地实践阶段,商汤此次进一步提出了发展“负责任且可评估”的人工智能,并将其作为商汤开展人工智能治理的愿景目标,打造伦理治理闭环。

人工智能治理进入3.0阶段,核心是负责任且需可评估

从发展历程看,人工智能治理至今已经经历了以原则讨论为主的1.0阶段,以政策讨论为主的2.0阶段。进入2022年,随着全球人工智能治理进程的持续推进,以及可信、负责任人工智能等相关理念的持续渗透,有关验证人工智能治理如何落地实施的倡议日益增多。人工智能治理开始进入以技术验证为主的3.0阶段,即落地实践阶段。

而目前,人工智能治理的落地实践仍面临许多挑战,各行各业需要重点处理“理念与行动”、“政策与实践”、“技术与用户”三组关系,即将人工智能伦理的共同原则付诸实施;将政策要求转化为技术和业务团队可执行的实践标准;深化用户对AI治理的理解、提升用户参与AI治理的能力,最终才能深入推进人工智能治理。

为有效地推进人工智能治理,商汤科技基于对全球人工智能治理诉求的分析,结合自身对技术和市场的理解,在白皮书中提出,“人工智能治理应当是一个价值牵引、技术先行、多方参与、分层推进的动态进程”,为人工智能治理的落地实践建立了有效路径。

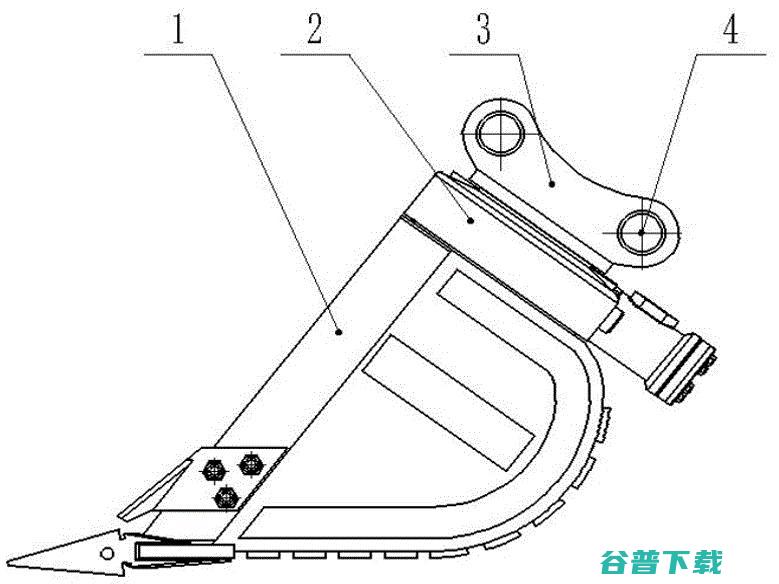

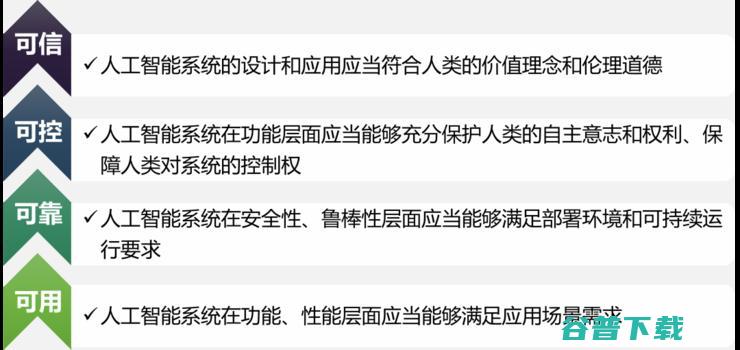

报告认为,从治理效果看,人工智能治理的实现由低至高,可分为可用、可靠、可控、可信四个层次。其中,“可用”是指人工智能系统在功能、性能层面应当能够满足应用场景需求;“可靠”是指人工智能系统在安全性、鲁棒性层面应当能够满足部署环境和可持续运营要求;“可控”是指人工智能系统在功能层面应当能够充分保护人类的自主意志和权利、保障人类对系统的控制权;“可信”是指人工智能系统的设计和应用应当符合人类的价值理念和伦理道德。

人工智能治理的“分层目标”

报告指出,人工智能治理体系建构的目标,就是发展负责任的人工智能;但相关工作不应停留在“口头上”、“纸面上”,还应做到有迹可循、有据可查。因此,基于“平衡发展”的伦理观,“以人为本、技术可控、可持续发展”的伦理原则,商汤此次提出发展“负责任且可评估”的人工智能,并将其作为开展人工智能治理的愿景目标。

“负责任且可评估的人工智能”的核心要求

构建覆盖全生命周期的治理体系,打造AI治理闭环

作为业界最先组建人工智能伦理与治理委员会,并将伦理治理工作当作公司战略级方向的科技创新企业之一,商汤自2020年1月统筹推进人工智能伦理治理工作体系建设以来,已在内部开展大量治理创新实践,并形成了一整套可评估的人工智能治理落地方案,将伦理原则嵌入到产品设计、开发、部署的全生命周期,初步形成了人工智能治理闭环。

在数据风险方面,商汤将个人信息保护融入产品研发全生命周期,设立“数据安全与个人信息保护委员会”,实施个人信息保护评估审查,确保产品遵循默认符合个人信息保护的设计要求。

在算法风险方面,商汤作为领先的人工智能企业,主动承担算法开发者的主体责任,针对商业化算法场景,开展基于真实场景下的算法验证与评测,实现 AI 技术的真正可信与可控。

在应用风险方面,商汤持续完善人工智能伦理治理体系,建立覆盖设计、开发、部署全生命周期的产品伦理风险审查流程;紧随全球人工智能行业发展变化,建立“全球AI伦理风险库”;定期组织员工进行人工智能伦理培训,持续完善内部伦理传播体系,不断提升员工伦理素养。

商汤AI治理闭环,推进构建负责任且可评估的AI

为保障人工智能治理体系的有效落实、推动形成伦理治理“人人有责”的企业文化,商汤还建立了伦理风险目标管理机制、伦理风险事件处置机制和伦理治理质量控制机制。此外,为推动发展“负责任且可评估”的人工智能,商汤还在内部开发了一系列覆盖数据治理、算法测评、模型体检、伦理审查的流程工具和技术平台。

随着人工智能逐渐深入产业应用,AI的发展与治理之间的关系越来越像汽车的“发动机”和“方向盘”一样,相辅相成、缺一不可。

版权文章,未经授权禁止转载。详情见 转载须知 。