云端AI芯片落地难题如何破解 (云端AI芯片)

提到AI的落地你最先会想到什么?

有人想到了AI芯片的利用率以及底层硬件的调度;有人想到AI芯片的算力效益;还有人想到算力服务。

AI的落地,能够为智慧城市的建设,更精准的天气的预测,构建更安全的网络环境等提供底层支撑。

但是,AI的落地依旧面对诸多的挑战。比如,如何才能将AI用起来?如何才能渐进式的实现AI的价值?如何基于AI发展算力经济?

这逐层渐进的问题,考验着所有提供AI技术以及想要使用AI技术的人。对于最底层的AI芯片的提供者,目前非常棘手的问题之一就是软件。

燧原科技创始人兼COO张亚林在2022世界人工智能大会上就表示:“根据过往落地实践,我们发现, AI数据中心因其软件运维复杂,普遍具有方案选型难、各厂商产品兼容未知等痛点,而且数据中心部署交付周期长、沟通成本高、项目管理周期长。 ”

软件问题,特别是基于云端高性能AI推理和训练芯片的上层软件和生态,限制着众多AI芯片创新者的发展。

燧原科技创始人、CEO赵立东认为,“生态的垄断是目前我们面临的最大挑战,而生态垄断的原因是紧耦合的软件和硬件。因此,我们一定要创新。”

为了解决当下云端AI芯片落地的挑战,不同的公司会从不同的维度突破软件和生态的挑战。

2022年9月3日,燧原科技在“算尽其用·定义AI算力中心新实践”云端算力产业应用论坛上给出了解决这一挑战的答案——云燧智算机(CloudBlazer POD)。

云燧智算机是针对大规模、集约化人工智能算力应用场景的高性能AI加速集群,有一站式预集成人工智能加速硬件、一体化开发与管理平台及配套人工智能应用软件与服务,适用于数字政府、科研院所、科创平台等。

简单来说, 燧原科技在解决高性能云端AI芯片落地给出的一个解题思路就是“开箱即用”。

何为开箱即用?在交付方式上,云燧智算机提供包括采购、安装、运维一体的交钥匙方案。

能够以这样的方式交付,还是因为云燧智算机采用一体化设计。

硬件的算力层面,基于燧原科技已经发布的自研AI高性能芯片。在典型配置下,云燧智算机每单元可达到8PFLOPS的TF32浮点算力,并且支持按需横向扩容,可支持数千卡规模集群, 能够实现顶级超算的E级算力。

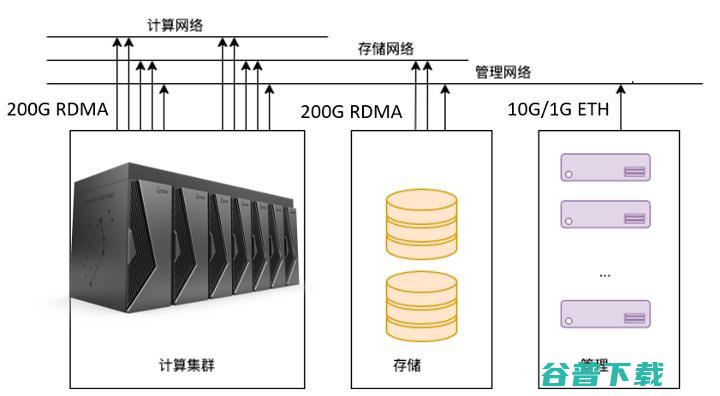

同时,云燧智算机也集成了合作伙伴的CPU,提供充足的算力。但计算集群除了算力这个核心要素之外,网络和存储和非常关键。

张亚林介绍,“云燧智算机代表了燧原科技经过多个大规模工程实践所形成的计算、网络、存储的整体设计:以全局优化为目标,基于计算、存储、管理网络分离,全互联无阻塞的网络架构,结合高效的多级存储方式,在‘邃思’AI芯片与CPU的异构算力支撑下,云燧智算机能够提供卓越的AI性能。”

了解到, 燧原科技的第一代和第二代“邃思”芯片已实际应用于大规模AI集群工程中,落地规模达千卡级别, 场景包括融媒体生成、城市智能感知等。

当然,提到计算集群就不得不关注数据中心整体能效(PUE),特别是在双碳目标以及绿色环保的总体趋势,以及东数西算有政策性要求。据悉,云燧智算机采用一体化冷板式液冷技术,实现单节点8颗高性能人工智能芯片液冷散热, PUE可降至1.1及以下。

前面提到,AI落地一个巨大的挑战就是软件。不过软件是一个很宽泛的概念,既需要能够提升AI芯片利用率的编译器、库等,也需要算力平台的管理软件。

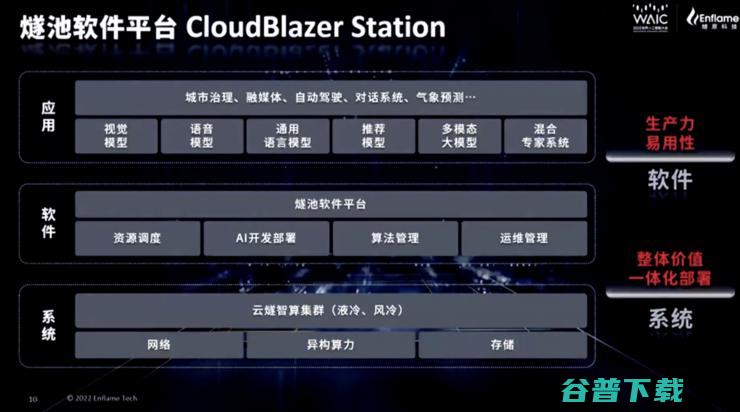

随最新推出的云燧智算机一起推出的是燧原科技提供燧池智算平台(CloudBlazer Station),包含基础设施层的异构算力调度平台,智能运维平台,驭算软件栈SDK,算法服务层的智能算法管理平台以及训推一体化平台。

同时,面对超大参数量的巨量模型趋势, 云燧智算机可支持超千亿参数巨量模型的高效、并行训练, 这主要是得益于云燧智算机计算节点内基于GCU-LARE2.0多芯互联技术提供近1TB/s的互联带宽,跨节点互联能力高达600Gb/s,可实现千卡级大规模集群高速互联。

开箱即用的计算集群确实能够在一定程度降低使用者的门槛,但计算集群毕竟是一个复杂的系统,最终能在多大程度上促进高性能AI计算的落地,还需要用更多的落地项目证明。

原创文章,未经授权禁止转载。详情见 转载须知 。